Modelo LLM usa otimização para aprimorar inteligência artificial

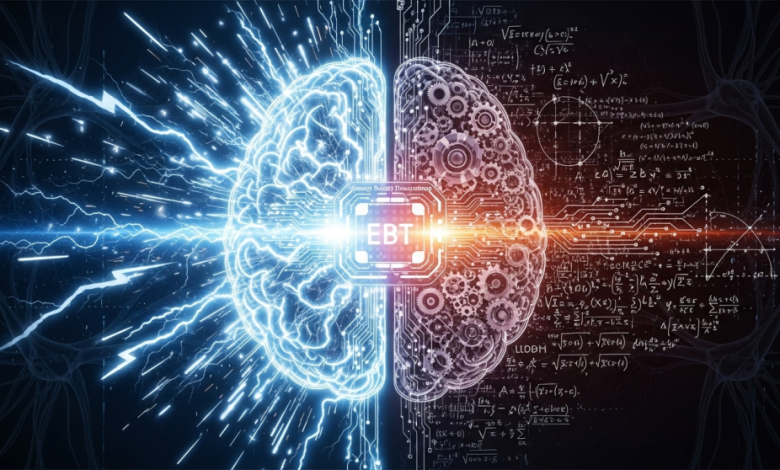

São Paulo — InkDesign News — Pesquisadores na Universidade de Illinois em Urbana-Champaign e na Universidade da Virgínia desenvolvem uma nova arquitetura chamada energy-based transformer (EBT), que promete aprimorar as capacidades de raciocínio em sistemas de inteligência artificial (IA) e modelos de linguagem em larga escala (LLM).

Tecnologia e abordagem

A arquitetura EBT utiliza um método de verificação baseado em uma função de "energia" para validar previsões em vez de apenas gerar respostas. Essa função avalia a compatibilidade entre uma entrada e uma previsão, atribuindo um valor de energia. Valores baixos indicam alta compatibilidade, enquanto valores altos sinalizam uma má correspondência. A ideia central é abordar o raciocínio como um processo de otimização, onde o modelo começa com uma previsão aleatória que é progressivamente refinada para minimizar a energia.

O modelo EBT combina as funções de gerador e verificador em uma única estrutura, permitindo uma alocação dinâmica de recursos computacionais. Isso permite que o sistema “pense” por mais tempo em problemas complexos, ao mesmo tempo em que é capaz de tratar a incerteza em cenários do mundo real.

Aplicação e desempenho

Os pesquisadores compararam EBTs com arquiteturas estabelecidas, como o transformer++ e o diffusion transformer (DiT), em dois critérios principais: “escala de aprendizado” e “escala de raciocínio”. Durante o pré-treinamento, os EBTs apresentaram uma eficiência superior, alcançando uma taxa de escalabilidade até 35% maior que a do transformer++.

Na fase de inferência, os EBTs superaram modelos existentes em tarefas de raciocínio. Ao “pensar mais” e realizar “autoverificação”, os EBTs melhoraram o desempenho em modelagem de linguagem em 29% em relação ao transformer++. Além disso, para tarefas como desnoising de imagens, os EBTs conseguiram resultados superiores com 99% menos passes de inferência.

Impacto e mercado

A pesquisa sugere que os EBTs não somente se destacam pela escalabilidade, mas também pela eficiência de dados, um fator crítico em um cenário onde a obtenção de dados de alta qualidade se torna um gargalo para o avanço da IA. Eles oferecem uma solução potencial para superar limitações enfrentadas pelas arquiteturas clássicas de transformers em LLMs.

“Os benefícios do pensamento em EBTs não são uniformes, mas escalam positivamente com mudanças distributivas, evidenciando o raciocínio como um mecanismo crítico para a generalização robusta”, dizem os pesquisadores.

Os próximos passos envolvem a integração da arquitetura EBT nas aplicações empresariais, especialmente nas que requerem decisões críticas em situações com dados limitados.

Fonte: (VentureBeat – AI)