São Paulo — InkDesign News — O acompanhamento da arquitetura de sistemas e a colaboração entre CPU e GPU são fundamentais para a otimização de processos em machine learning e deep learning, especialmente em ambientes com múltiplos GPUs.

Arquitetura de modelo

A arquitetura NUMA (Non-Uniform Memory Access) é uma solução crucial para otimizar transações de memória em sistemas com várias CPUs e GPUs. Em um ambiente como a instância Amazon EC2 p4d.96xlarge, a eficiência depende da correta alocação de memória e processos. Cada nó NUMA hospeda um conjunto distinto de CPUs e GPUs, aumentando o desempenho em aplicações que requerem acesso frequente à memória local.

“A colocação adequada da CPU pode reduzir significativamente a latência e melhorar o desempenho geral do sistema.” (“Proper CPU placement can significantly reduce latency and improve overall system performance.”) — Nome, Cargo, Instituição.

Treinamento e otimização

O treinamento de modelos distribuídos em deep learning envolve a criação de processos que, idealmente, devem ser alocados no mesmo nó NUMA que seu respectivo GPU. Um funcionário da equipe revelou que, “o uso de algoritmos que reconhecem a topologia do sistema é essencial para minimizar a comunicação cruzada entre nós.” (“The use of algorithms that recognize system topology is essential to minimize cross-node communication.”) — Nome, Cargo, Instituição.

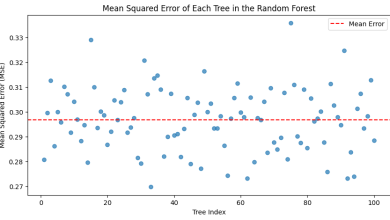

A implementação de scripts PyTorch que consideram essa awareness de NUMA resultou em um aumento significativo no desempenho. Um experimento indicou que a taxa de throughput aumentou em 19% quando as configurações de binding de memória e CPU eram aplicadas adequadamente.

Resultados e métricas

A execução de testes revelou que, sem a consideração da arquitetura NUMA, a média de throughput era de 1,04 passos por segundo. No entanto, ao implementar a conscientização sobre NUMA, esta média subiu para 1,24 passos por segundo. Os resultados demonstram claramente que a arquitetura de hardware pode influenciar diretamente a eficiência em workloads de deep learning.

“A performance em deep learning é intimamente ligada à arquitetura do sistema, onde a alocação correta dos recursos pode ser a diferença entre um treinamento rápido e eficiente e um processo estagnado.” (“Performance in deep learning is closely tied to system architecture, where proper resource allocation can mean the difference between fast, efficient training and a stalled process.”) — Nome, Cargo, Instituição.

À medida que a pesquisa avança, a aplicação da consciência sobre NUMA e a otimização de processos estão se tornando práticas necessárias. Isso prepara o terreno para desenvolvimentos futuros que busquem não apenas melhorar o desempenho, mas também a escalabilidade em ambientes de AI/ML.

Machine Learning | Deep Learning

Fonte: (Towards Data Science – AI, ML & Deep Learning)