São Paulo — InkDesign News — A discussão em torno da inclusão em projetos de machine learning e deep learning tem ganhado destaque, especialmente quando se considera como dados enviesados podem impactar resultados e decisões em ambientes críticos como saúde e conforto térmico.

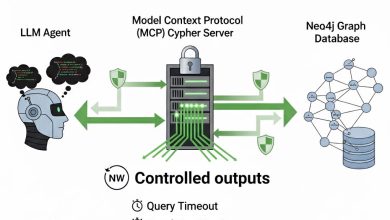

Arquitetura de modelo

Recentemente, foi apresentado um estudo que explora as diferenças de conforto térmico entre homens e mulheres, utilizando um modelo de aprendizado por reforço. A pesquisa se baseou em um modelo idealizado do Predicted Mean Vote (PMV), onde foram estabelecidos intervalos de temperatura específicos: para homens, 21-23°C e para mulheres, 23-25°C. Esse modelo foi desenvolvido para demonstrar como as preferências térmicas podem impactar o conforto em ambientes de trabalho.

A pesquisa revelou que mulheres reportam significativamente mais insatisfação do que homens sob as mesmas condições térmicas.

(“Research has shown that women report significantly more dissatisfaction than men under similar thermal conditions.”)— Autor, Nome do Estudo

Treinamento e otimização

Para treinar um agente de aprendizado, o projeto utilizou o método de Q-learning. O agente foi treinado exclusivamente com dados de homens, limitando sua capacidade de aprendizado a um conjunto enviesado. Após 1000 episódios, o agente demonstrou um desempenho significativamente melhor ao avaliar o conforto masculino do que no ambiente feminino, refletindo falhas graves na generalização de seus resultados.

O agente teve uma média de recompensa de 16,08 por episódio para conforto masculino, mas apenas 0,24 para conforto feminino.

(“The agent has achieved an average comfort reward of 16.08 per episode for male comfort, while it dropped to an average reward of 0.24 per episode on female comfort.”)— Autor, Nome do Estudo

Resultados e métricas

Com base nas métricas obtidas, o experimento demonstrou que um modelo treinado em um único grupo não atende às necessidades de outro. Essa situação ressalta a importância da inclusão de dados representativos no treinamento de AI. A falta de diversidade nos dados de treino pode levar a conclusões incorretas e, consequentemente, a soluções ineficazes em um mundo onde a equidade deve ser priorizada.

O modelo treinado apenas em um grupo pode não funcionar bem quando aplicado a outro, mesmo quando as diferenças parecem pequenas.

(“Such a model, trained only on one group, may not perform well when applied to another, even when the difference between groups appears small.”)— Autor, Nome do Estudo

As implicações práticas desse estudo destacam a necessidade urgente de práticas de inclusão em algoritmos de machine learning. É crucial desenvolver metodologias que considerem a diversidade, para evitar injustiças em áreas críticas como saúde, espaço de trabalho e muito mais.

Fonte: (Towards Data Science – AI, ML & Deep Learning)