São Paulo — InkDesign News — Nos últimos anos, o desenvolvimento em machine learning e deep learning tem avançado de forma significativa, particularmente com o surgimento de modelos de linguagem e áudio que transformam a forma como interagimos com a tecnologia.

Arquitetura de modelo

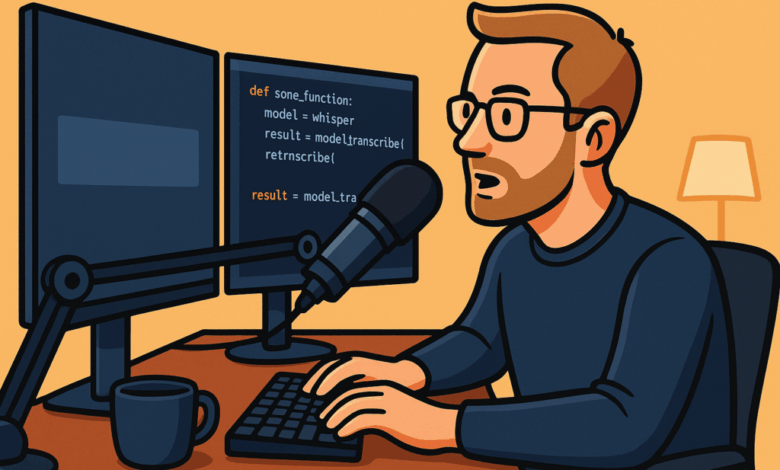

Um exemplo notável é o modelo Whisper da OpenAI, que combina transcrição de voz, síntese de fala e comunicação em tempo real. Este modelo foi projetado para entender e processar o discurso humano com alta precisão, utilizando uma arquitetura robusta que considera as nuances da comunicação oral.

“A transcrição da OpenAI captura quase todas as minhas palavras, com muito poucos erros. Mesmo com termos menos comuns, como siglas da ciência da computação, ele ainda consegue entender o que estou dizendo.”

(“OpenAI’s transcription almost always captures all of my words, with very few mistakes. Even if I use less common words, for example, acronyms related to computer science, it is still able to pick up what I am saying.”)— Autor, Programador

Treinamento e otimização

O Whisper é treinado utilizando um conjunto de dados massivo que abrange diversas linguagens e contextos de fala. Isso permite que o modelo seja altamente eficiente e preciso, com taxas de erro significativamente reduzidas em comparação com soluções anteriores. O tempo de treinamento é otimizado através de técnicas modernas, como transfer learning, garantindo que o modelo aprenda de forma eficiente e eficaz.

Resultados e métricas

Os resultados do Whisper têm mostrado um desempenho superior em benchmarks de transcrição, com precisão frequentemente superior a 90%. Isso se deve à sua capacidade de processar áudio em tempo real e gerar transcrições quase perfeitas. Os usuários relatam uma economia de tempo ao usar o modelo para transcrições diárias e tarefas de programação, prometendo um impacto significativo na produtividade.

“Se cada uso do modelo economiza 30 segundos, e você o usa 20 vezes por dia, isso economiza dez minutos do seu dia.”

(“If each model usage saves you 30 seconds, and you use it 20 times per day, you have just saved ten minutes of your day.”)— Autor, Programador

Essa tecnologia não só melhora a forma como nos comunicamos, mas também abre novos caminhos para aplicações em assistentes virtuais, educação e acessibilidade. A próxima etapa envolve a integração de modelos de áudio com sistemas de resposta mais complexos, potencializando ainda mais a experiência do usuário.

Fonte: (Towards Data Science – AI, ML & Deep Learning)