Machine learning aprende com feedback humano de forma simples

São Paulo — InkDesign News — O recente avanço em modelos de linguagem de grande porte, como o ChatGPT, revolucionou a percepção da inteligência artificial, especialmente nas áreas de machine learning e deep learning. Técnicas como mineração de dados e aprendizado por reforço têm transformado a forma como interagimos com essa tecnologia.

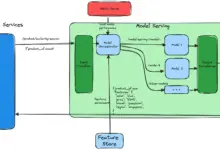

Arquitetura de modelo

O ChatGPT se baseia em uma versão aprimorada do GPT-3, incorporando inovações que vão além do aumento de dados e complexidade arquitetônica. O algoritmo de aprendizado por reforço a partir do feedback humano (RLHF) está no cerne dessa transformação, permitindo uma abordagem mais eficaz em comparação com os métodos tradicionais.

A ideia que vamos estudar é exatamente essa: queremos que o humano escolha uma resposta entre duas opções para criar o conjunto de dados anotados.

(“The idea we are going to look at is based exactly on that: we want the human to just choose an answer from two possible options to create the annotated dataset.”)— Autor, Instituição

O treinamento inicial envolve uma fase de pré-treinamento focada em modelagem de linguagem, onde o modelo tenta prever um token oculto no contexto. O ajuste fino é realizado em tarefas específicas como geração de texto, tradução e resposta a perguntas, que tradicionalmente dependem de conjuntos de dados anotados manualmente.

Treinamento e otimização

Os desafios de anotação de dados são notáveis, pois estas tarefas são demoradas e não escaláveis. Para contornar isso, o RLHF simplifica o processo, utilizando notas binárias em vez de dados anotados extensivos. O modelo recompensa utiliza essa informação para avaliar e ajustar o comportamento do modelo original.

“Uma maneira interessante de utilizar essa função de perda é que o modelo aprende recompensas apropriadas para textos gerados por si mesmo.”

(“A nice thing about using such a loss function is that the model learns appropriate rewards for generated texts by itself.”)— Autor, Instituição

O treinamento do modelo de recompensas é realizado com uma arquitetura semelhante à do LLM inicial, onde em vez de gerar sequências de texto, este modelo fornece um valor numérico, estimando a qualidade das respostas geradas.

Resultados e métricas

Comparando as estimativas de respostas boas e ruins, a função de perda gera insights sobre o desempenho do modelo. Se a diferença nas recompensas for negativa, ajustes significativos são necessários. Com um bom desempenho, as perdas permanecem em níveis baixos, indicando que o modelo distingue efetivamente entre respostas de qualidade.

“Este método permite que o modelo aprenda de forma autônoma, sem a necessidade de avaliações numéricas extensivas.”

(“This approach allows the model to learn autonomously, without needing extensive numerical evaluations.”)— Autor, Instituição

A aplicação do RLHF em modelos populares, incluindo ChatGPT, representa um avanço no treinamento escalável de modelos de linguagem. As oportunidades de pesquisa futura se concentram em melhorias contínuas com feedback em tempo real, utilizando a interação do usuário para refinar ainda mais as respostas geradas.

Fonte: (Towards Data Science – AI, ML & Deep Learning)