Empresa chinesa lança novas referências de inteligência artificial

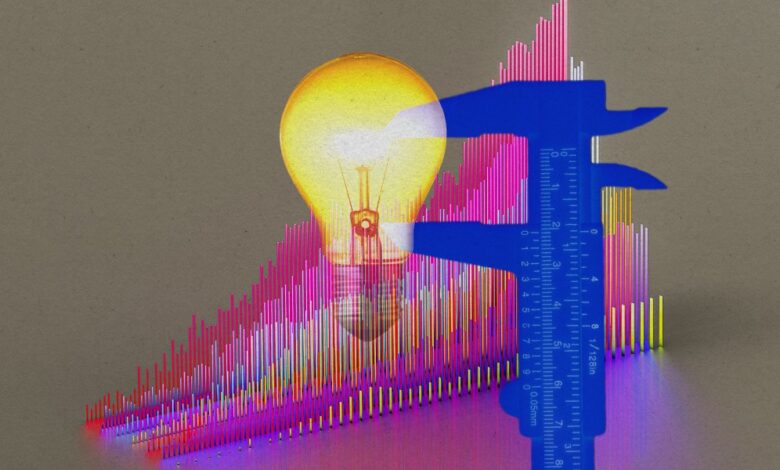

São Paulo — InkDesign News — O desenvolvimento de métricas de avaliação para modelos de inteligência artificial (IA) tem avançado, com novas abordagens surgindo para determinar o valor econômico e a eficácia das tecnologias emergentes, como evidenciado pelo projeto Xbench.

Contexto da pesquisa

A motivação por trás do projeto Xbench surgiu em 2022, impulsionada pelo sucesso do ChatGPT, com o objetivo de avaliar quais modelos de IA merecem investimento. Liderado por Gong Yuan, a equipe inicialmente trabalhou em uma ferramenta interna, que agora se expandiu com a colaboração de pesquisadores e profissionais externos. A equipe se inspirou em benchmarks acadêmicos existentes e reconhece a necessidade de uma avaliação mais robusta das capacidades dos modelos.

Método e resultados

Xbench adota duas abordagens principais para a avaliação das capacidades das IA. A primeira é similar a benchmarks tradicionais, como o GPQA e o SuperGPQA, que avaliam o conhecimento em diversas disciplinas por meio de perguntas elaboradas e revisadas. O sistema Xbench-ScienceQA abrange temas desde bioquímica até mecânica orbital, valorizando não apenas a resposta correta, mas também a lógica que a suporta.

A segunda abordagem, Xbench-DeepResearch, analisa a habilidade de navegar pela web em língua chinesa. Desenvolvedores criaram um conjunto de 100 perguntas que exigem pesquisa aprofundada, cobrindo tópicos como música, história e finanças. O sistema favorece a consistência dos dados e a diversidade de fontes, além de premiar a honestidade dos modelos ao indicarem quando não há informações suficientes. Um exemplo notável é a questão sobre quantas cidades chinesas nas três províncias noroeste fazem fronteira com um país estrangeiro, tarefa que apenas 33% dos modelos responderam corretamente.

Implicações e próximos passos

A equipe de Xbench se comprometeu a atualizar as questões trimestralmente e a manter um conjunto de dados semi-público. Para aferir a prontidão dos modelos para aplicações do mundo real, os pesquisadores criaram tarefas que imitam fluxos de trabalho, como a identificação de candidatos qualificados para uma posição de engenharia. Novas categorias de avaliação estão por vir, incluindo finanças e design, embora os detalhes ainda não tenham sido divulgados. A complexidade em quantificar a colaboração e a criatividade das IA ainda representa um desafio significativo.

“É realmente difícil para os benchmarks incluir aspectos que são tão difíceis de quantificar. Mas Xbench representa um início promissor.”

(“It is really difficult for benchmarks to include things that are so hard to quantify. But Xbench represents a promising start.”)— Zihan Zheng, Pesquisador, NYU

O desempenho da ChatGPT-o3 destaca-se nas categorias de recrutamento e marketing, superando seus concorrentes, como Perplexity Search e Claude 3.5 Sonnet. Este avanço evidencia como novos métodos de avaliação podem mudar o cenário da inteligência artificial, proporcionando insights valiosos sobre as capacidades e limitações dos modelos.

A pesquisa contínua nesta área não apenas formará uma base sólida para futuras inovações em IA, mas também levantará questões éticas significativas sobre a utilização da IA em processos que impactam diretamente a vida das pessoas.

Fonte: (MIT Technology Review – Artificial Intelligence)