Vision Transformer reduz custos em projetos de machine learning

São Paulo — InkDesign News — Em um avanço notável na área de machine learning, o modelo Data-efficient image Transformer (DeiT) promete transformar a forma como modelos de visão computacional são treinados, reduzindo drasticamente a necessidade de dados rotulados.

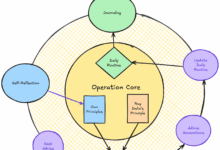

Arquitetura de modelo

O DeiT é derivado do Vision Transformer (ViT), mas com inovações significativas que o tornam mais acessível para treinamento. Utilizando uma técnica chamada distilação de conhecimento, o DeIT permite que modelos menores aprendam de um modelo maior (RegNet), permitindo um uso mais eficiente de dados.

“Assim, com esse mecanismo, o modelo do aluno basicamente obtém conhecimento tanto do conjunto de dados quanto do professor simultaneamente.”

(“So, with this mechanism, the student essentially derives knowledge from both the dataset and the teacher simultaneously.”)— Autor Desconhecido, Artigo.

A arquitetura do DeiT incorpora tokens de classe e um token de destilação, permitindo que o aprendizado seja otimizado ainda mais. O modelo foi testado com diferentes tamanhos, revelando uma capacidade robusta de aprender a partir de conjuntos de dados reduzidos.

Treinamento e otimização

Tradicionalmente, o ViT exigia até 300 milhões de imagens para um treinamento efetivo, enquanto o DeiT consegue resultados equivalentes com apenas 1 milhão. Essa redução é essencial para a viabilidade de implementações práticas em contextos onde a coleta de dados é limitada.

“O modelo precisa de apenas 1 milhão de imagens (conjunto de dados ImageNet-1K). Isso representa 300 vezes menor!”

(“The original ViT needed 300 million images for training, while DeiT relies only on 1 million images (ImageNet-1K dataset). That’s 300x smaller!”)— Autor Desconhecido, Artigo.

Além disso, a implementação do DeiT oferece flexibilidade para ajustar parâmetros, o que é um aspecto importante para otimizar o desempenho conforme as necessidades específicas do projeto.

Resultados e métricas

Os experimentos demonstraram que o DeiT supera até mesmo o ViT em cenários de dados limitados, apresentando uma acurácia notável em testes com o conjunto de dados ImageNet-1K. Os resultados mostraram que o DeiT com um mecanismo de distilação proposto superou o ViT, mesmo sem acesso ao extenso conjunto de dados JFT-300M.

“A precisão melhorou ainda mais quando o mecanismo de distilação inovador foi aplicado e o modelo foi ajustado usando as mesmas imagens ampliadas.”

(“The accuracy improved even further when the novel distillation mechanism was applied and the model was fine-tuned using the same images upscaled to 384×384.”)— Autor Desconhecido, Artigo.

Os resultados indicam não apenas uma melhoria em termos de precisão, mas também em velocidade de processamento. Isso é crucial para a adoção em aplicações do mundo real, como triagem de imagens em tempo real.

Conforme a pesquisa avança, o DeiT e suas variações oferecem um caminho promissor para abordagens de machine learning mais eficientes e menos dependentes de grandes quantidades de dados. Isso abre oportunidades para aplicações em áreas onde a coleta de dados é um desafio, como na medicina e no monitoramento ambiental.

Fonte: (Towards Data Science – AI, ML & Deep Learning)