São Paulo — InkDesign News — A multiplicação de matrizes é uma operação central em machine learning e deep learning, sendo crucial em tarefas como simulações físicas e computação científica. Um novo estudo explora a implementação eficiente de multiplicação de matrizes com GPUs utilizando Triton.

Arquitetura de modelo

O artigo descreve a implementação do GEMM (General Matrix-Matrix Multiplication), um dos pilares para operações em GPUs. O enfoque inicial é numa implementação ingênua que, embora simples e compreensível, revela-se ineficiente em termos de acesso à memória e cache. O uso de memória compartida é reforçado como uma abordagem fundamental.

“Essa operação envolve calcular os produtos escalares de todos os pares de linhas e colunas em X e Y, respectivamente.”

(“This operation involves computing the dot products of all pairs of rows and columns in X and Y respectively.”)— Autor, Artigo

Treinamento e otimização

Uma das soluções apresentadas é o uso de tiling, onde grandes matrizes são dividas em tiles menores. A pesquisa também analisa o papel da hierarquia de memória nas GPUs, incluindo registros, memória compartilhada e memória de alta largura de banda (HBM). O tamanho do bloco é uma consideração crítica, com BLOCO_TAM de 64 sendo uma escolha inicial comum.

“A memória é gerenciada de forma que maximizar a performance seja fundamental.”

(“Memory is managed in such a way that maximizing performance is critical.”)— Autor, Artigo

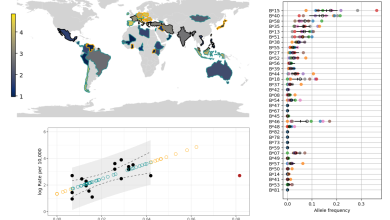

Resultados e métricas

Os testes realizados mostraram que a versão otimizada com acesso à memória coalesced teve uma latência mediana de 261,9420 ms, com taxa de transferência de 1,5741 TeraFLOPS. No entanto, essa performance foi inferior a uma implementação anterior, evidenciando que, mesmo otimizações bem-intencionadas podem introduzir gargalos.

Medidas indicaram que o primeiro modelo apresentou uma execução mais eficiente, sendo qualificado como limitado por computação, enquanto a versão coalescida enfrentou congestionamentos, resultando em latência vinculada.

Esses resultados ressaltam a importância da análise empírica na validação de técnicas de otimização em machine learning. Para futuras pesquisas, o artigo sugere investigar o impacto de outros métodos de otimização em kernels de GPU.

Com isso, o campo de otimização de operações em matrizes permanece vibrante, prometendo avanços significativos em aplicações práticas de IA e ML.

Fonte: (Towards Data Science – AI, ML & Deep Learning)