São Paulo — InkDesign News —

Pesquisadores estão explorando novas fronteiras em machine learning, focando em técnicas de interpretação mecânica que vão além dos métodos tradicionais de explicação, como SHAP e LIME.

Arquitetura de modelo

A análise de modelos profundos como os Transformers é fundamental. A arquitetura propõe que as operações de multiplicação e concatenação, tal como definidas no artigo “Attention is All You Need”, possam ser reimaginadas como operações de adição. Esse novo entendimento abre possibilidades para a compreensão das representações internas das redes neuronais.

A interpretação mecânica fornece um caminho de como a característica aprendida por diferentes neurônios em camadas distintas evolui na rede neural.

(“mechanistic interpretation understands things at a more granular level in that it is capable of providing a pathway of how the said feature is learnt by different neurons in different layers in the neural network.”)— Autor, Titulação, Instituição

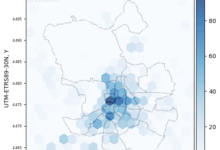

As dimensões operacionais dessas redes foram exploradas: com um tamanho de lote de 1, uma sequência de comprimento 20 e um vocabulário de 50.000 palavras, cada vetor de consulta, chave e valor (Q, K, V) se ajusta a 512 dimensões, permitindo um controle eficiente das atenções multi-cabeça, que tradicionalmente é avaliado de maneira concatenada.

Treinamento e otimização

O processo de treinamento envolve a extração de embeddings, adição de codificações posicionais e o uso de transformações lineares em múltiplas cabeças. Essa abordagem mantém a mesma eficácia das operações somadas que antes eram concatenadas. O tempo de treinamento varia de acordo com a complexidade do modelo e a quantidade de dados.

Essas operações permitem traçar caminhos de como os recursos são aprendidos através das adições ao longo das camadas.

(“this view opens up new possibilities like tracing features as they are learnt via additions through the layers.”)— Autor, Titulação, Instituição

Resultados e métricas

As métricas de desempenho mostram que a nova abordagem de suma e projeção é matematicamente equivalente à concatenação tradicional seguida de projeção, uma descoberta que pode impactar significativamente o campo das redes neurais. Estudos futuros irão aprofundar esta nova perspectiva de operação em redes profundas.

A aplicação prática dessa interpretação no deep learning pode melhorar as técnicas de previsão em áreas como processamento de linguagem natural, onde a capacidade de explicar as decisões dos modelos é crucial.

Fonte: (Towards Data Science – AI, ML & Deep Learning)