O uso de técnicas de machine learning tem revolucionado o campo da geração de imagens, especialmente com o surgimento de novas abordagens que eliminam a necessidade de geradores tradicionais. Pesquisadores do MIT apresentaram métodos inovadores que podem alterar a forma como as imagens são manipuladas e geradas.

Contexto da pesquisa

A geração de imagens por meio de IA geralmente envolve redes neurais que precisam ser treinadas em vastos conjuntos de dados de milhões de imagens. Este processo consome um tempo significativo e recursos computacionais. O grupo de pesquisa do MIT, sob a orientação de Lukas Lao Beyer, desenvolveu uma nova técnica que utiliza um tokenizer unidimensional, capaz de representar imagens de forma altamente comprimida.

Método proposto

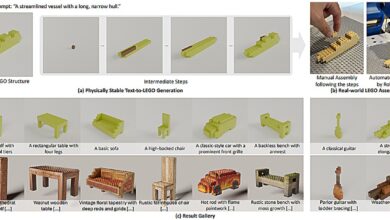

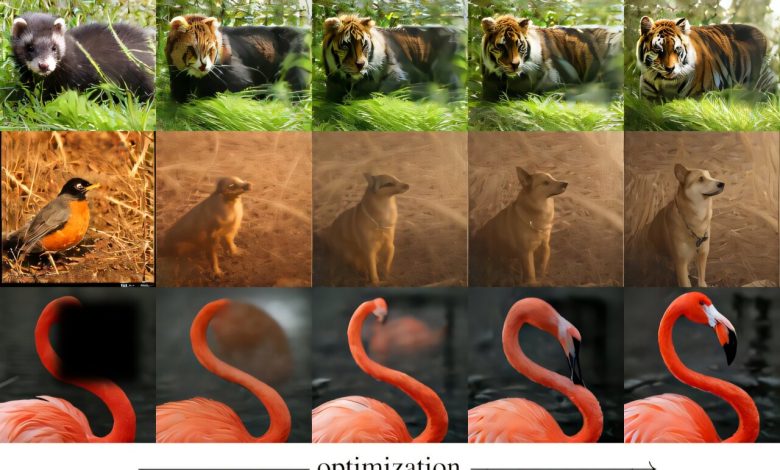

O modelo proposto baseia-se em um tokenizer unidimensional que traduz uma imagem de 256×256 pixels em uma sequência de apenas 32 números, chamados tokens. Com isso, as informações visuais são incorporadas de maneira eficiente. Ao modificar esses tokens, os pesquisadores conseguiram afetar diretamente atributos da imagem, como qualidade e luminosidade. Em um experimento, uma modificação em um token alterou a resolução da imagem, enquanto outro influenciou a aparência de desfoque.

“Esta foi uma descoberta sem precedentes, pois ninguém havia observado alterações visualmente identificáveis a partir da manipulação de tokens.”

(“This was a never-before-seen result, as no one had observed visually identifiable changes from manipulating tokens.”)— Lukas Lao Beyer, Pesquisador, MIT

Resultados e impacto

Os resultados indicaram que, através da utilização do tokenizer e de um decodificador, as imagens podem ser criadas sem a necessidade de um gerador. Isso não apenas simplifica o processo de geração, mas também potencialmente reduz custos computacionais, uma vez que evita o treinamento extensivo dos modelos geradores. Os pesquisadores demonstraram que, a partir de tokens aleatórios, imagens poderiam ser iterativamente ajustadas para corresponder a descrições textuais.

“Descobrimos que novas capacidades podem surgir quando se juntam essas diferentes peças.”

(“But we did discover that new capabilities can arise when you put all these pieces together.”)— Sertac Karaman, Professor, MIT

As implicações dessa pesquisa são vastas e podem se estender além do campo da visão computacional. Os pesquisadores sugerem que a metodologia pode ser aplicada em áreas como a robótica, onde as ações dos veículos autônomos podem ser tokenizadas de maneira semelhante.

Fontes: (TechXplore – Machine Learning & AI)