Shape-First Tune-Up reduz 79% dos custos MongoDB com modelagem

São Paulo — InkDesign News —

O uso eficiente de machine learning tem se mostrado crucial para otimizar sistemas de bancos de dados em larga escala. Um recente estudo apresenta técnicas que reduziram em 79% os custos de MongoDB enquanto melhoraram a latência em 92%, demonstrando a importância do design de consultas para aplicações que dependem de aprendizado de máquina.

Arquitetura de modelo

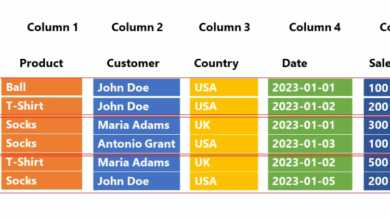

O problema identificado foi uma escalada automática de recursos na nuvem do MongoDB de M20 para M60, aumentando a fatura em 20% da noite para o dia. Três principais causas foram detectadas usando o profiler: uma cascata N + 1 de queries, cursores ilimitados em grandes volumes de dados históricos e documentos gigantes (jumbo docs) sobrecarregando o sistema. Esses desafios impactam diretamente o desempenho, o custo computacional e a eficiência das operações de machine learning que dependem de consultas rápidas e precisas.

“Finance says the new spend wipes out nine months of runway. We need a fix before stand-up.”

“A área financeira informou que o novo gasto elimina nove meses de orçamento. Precisamos de uma solução antes da reunião diária.”— COO, 02:38

Treinamento e otimização

Para mitigar o problema, a equipe substituiu as queries N + 1 com $lookup, incorporando a agregação para reduzir múltiplos acessos a um único. Também foram aplicados filtros de projeção e limites para controlar o volume de dados carregados com a função limit() e TTL para expiração automática dos dados antigos. Os documentos jumbo foram particionados em metadados leves e blobs armazenados externamente via GridFS ou S3, permitindo que os dados acessados com frequência permanecessem otimizados para acessos rápidos de machine learning.

“Latency p95: 2 300 ms → 160 ms. Read ops: 101 → 1 (‑99 %).”

“Latência p95: 2.300 ms → 160 ms. Operações de leitura: 101 → 1 (‑99%).”— Engenheiro de Dados

A reorganização dos índices, priorizando chaves de alta cardinalidade e evitando leituras cegas com $regex, eficiência aumentada e redução no custo computacional das consultas. O desenvolvimento utilizou ferramentas como o profiler do MongoDB, VS Code para ajustes, e painéis do Grafana para monitoramento em tempo real, garantindo melhoria de desempenho e visibilidade das métricas.

Resultados e métricas

Os resultados indicaram uma redução de custos de US$ 15.284 para US$ 3.210 mensais, uma queda de 79%. A latência no percentil 95 caiu de 1,9 segundos para 140 milissegundos, melhorando a experiência de sistemas que utilizam deep learning para processar grandes volumes de dados. O uso inteligente de TTL eliminou 72% do armazenamento de eventos antigos, enquanto a divisão de documentos jumbo aumentou em 22 pontos percentuais a taxa de acertos de cache, ambas essenciais para a eficiência de pipelines de aprendizado profundo.

“Fix shape first, then index once. Every reshaped document shrinks every future fetch, cache line, and replication packet.”

“Conserte primeiro o formato, depois crie o índice uma vez. Cada documento remodelado diminui todo fetch futuro, linha de cache e pacote de replicação.”— Hayk Ghukasyan, Chief of Engineering, Hexact

Além disso, práticas de paginação eficiente substituíram a paginação por offset, reduzindo leituras desnecessárias e melhorando a escala do sistema sob cargas elevadas típicas de operações de machine learning em produção. A equipe enfatiza que o redesenho estrutural dos dados é uma prioridade maior que a simples criação de índices, sugerindo uma mentalidade “shape-first” para sustentabilidade técnica e financeira.

Proximamente, a aplicação dessas técnicas pode ser estendida ao uso de modelos de deep learning que requerem acesso eficiente a dados de alta dimensionalidade, melhorando a responsividade e o custo-benefício de sistemas baseados em inteligência artificial. Novas pesquisas podem explorar automatização dessas otimizações integrando profiling dinâmico e ajustes em tempo real.

Para saber mais sobre machine learning e otimizações em bancos NoSQL, visite nossa seção dedicada.

Fonte: (Towards Data Science – AI, ML & Deep Learning)