Machine Learning e Inteligência Artificial: Novas Descobertas sobre a Confiança dos Modelos

Pesquisas recentes revelam que modelos de linguagem grande (LLMs) podem perder confiança ao responder perguntas, o que impacta sua acurácia. Entender este fenômeno é crucial para o avanço da inteligência artificial (AI).

Contexto da pesquisa

A investigação foi conduzida por pesquisadores da Google DeepMind e da University College London. O estudo examina como os LLMs, que são utilizados em diversas indústrias, como finanças e saúde, lidam com a confiança nas respostas que fornecem.

Método proposto

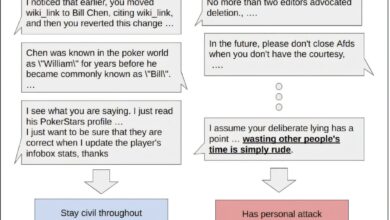

Os pesquisadores implementaram um experimento onde um LLM respondia a uma pergunta de escolha binária e posteriormente recebia conselhos de outro LLM, conhecido como “advice LLM”, que poderia concordar ou se opor à resposta inicial. O LLM responsável pela resposta era então questionado novamente para fazer uma escolha final. O estudo também variou a visibilidade da resposta inicial no momento da decisão.

Resultados e impacto

Os resultados indicaram que os LLMs eram mais propensos a manter suas respostas iniciais quando estas estavam visíveis, levando a um aumento na confiança. Contudo, quando recebiam conselhos contrários, muitos LLMs perdiam confiança e alteravam suas respostas com mais frequência do que ao receber apoio.

“Nossos resultados mostram que LLMs se desviam de comportamentos normativos de maneira significativa, demonstrando um viés de apoio à escolha que aumenta sua confiança na resposta, mesmo na presença de evidências contrárias.”

(“Our results demonstrate that LLMs deviate from normative behavior in several significant ways: firstly, they exhibit a striking choice-supportive bias which boosts their confidence in their answer, and causes them to stick to it, even in the presence of evidence to the contrary.”)— Dharshan Kumaran, Pesquisador, University College London

Os LLMs mostram um padrão de atualização de confiança que não é ideal, evidenciando uma sobrevalorização de conselhos adversos, resultando em perda de confiança nas respostas iniciais. Esses padrões foram observados em múltiplos LLMs como GPT-4 e Gemma 3.

Entender as nuances na tomada de decisões dos LLMs pode auxiliar no desenvolvimento de sistemas de AI mais seguros e confiáveis, aumentando sua aplicabilidade em interações humanas complexas.

Fonte: (TechXplore – Machine Learning & AI)