Redes neurais enfrentam desafios em reconhecer objetos fragmentados

Como humanos superam a IA no reconhecimento de objetos fragmentados

Machine learning e inteligência artificial continuam a evoluir, mas uma nova pesquisa revela que os sistemas de IA ainda enfrentam desafios consideráveis no reconhecimento de objetos, especialmente quando as imagens estão fragmentadas.

Contexto da pesquisa

Um estudo realizado pelo NeuroAI Lab da EPFL (Escola Politécnica Federal de Lausanne) investigou como humanos e IA lidam com tarefas visuais desafiadoras. Focados na integração de contornos, os pesquisadores buscaram compreender a diferença na capacidade de reconhecimento entre as duas entidades. O estudo foi apresentado na Conferência Internacional de Aprendizado de Máquina (ICML 2025) em Vancouver, de 13 a 19 de julho.

Método proposto

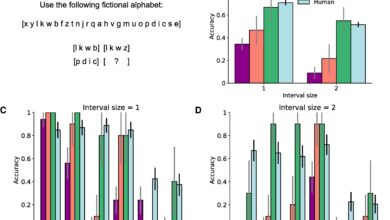

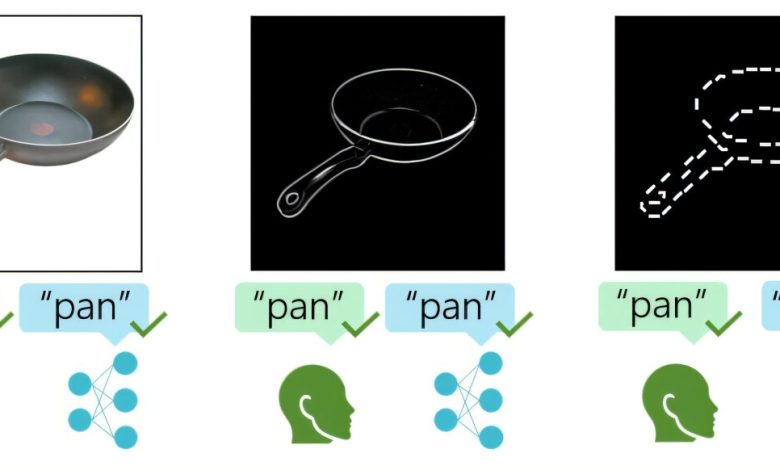

A equipe utilizou um conjunto de testes de reconhecimento de objetos, com 50 voluntários, analisando imagens de itens do dia a dia cujos contornos foram sistematicamente apagados ou fragmentados. Em paralelo, mais de 1.000 modelos de redes neurais artificiais (ANNs) foram desafiados com as mesmas tarefas. As condições variaram, afetando o tipo e a quantidade de informações visuais disponíveis.

Resultados e impacto

Os resultados indicaram que humanos mantiveram uma precisão de cerca de 50% mesmo com a maior parte do contorno de um objeto ausente. Em contraste, os modelos de IA tendiam a adotar palpites aleatórios sob essas mesmas condições. Apenas aqueles treinados com bilhões de imagens exibiram desempenho próximo ao humano, embora precisassem ser adaptados para as imagens do estudo. Os pesquisadores notaram que humanos apresentam uma preferência natural por reconhecer objetos cujas partes fragmentadas apontam na mesma direção, um fenômeno denominado “viés de integração”.

A pesquisa sugere que a integração de contornos não é uma característica inata, mas pode ser aprendida pela experiência.

(“The research suggests that contour integration is not a hardwired trait but instead can be learned from experience.”)— Ben Lönnqvist, Estudante de Pós-Graduação, EPFL

Esses achados têm implicações significativas para indústrias que dependem de visão computacional, como carros autônomos e imagens médicas. A possibilidade de desenvolver IA que “vê” o mundo de maneira semelhante a humanos pode levar a tecnologias mais seguras e confiáveis.

Próximos passos incluem treinar sistemas de IA com uma dieta visual mais “humana”, utilizando imagens reais em que os objetos muitas vezes estão parcialmente escondidos.

Fonte: (TechXplore – Machine Learning & AI)