São Paulo — InkDesign News — A crescente adoção de sistemas baseados em machine learning e deep learning expõe desafios críticos relacionados à responsabilização e atribuição de culpa em falhas desses sistemas, destacando um fenômeno conhecido como scapegoating moral no uso de Inteligência Artificial (IA).

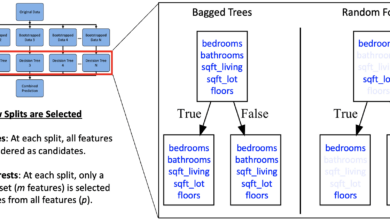

Arquitetura de modelo

Pesquisas recentes investigam como a percepção humana dos modelos de IA, especialmente quando estes são antropomorfizados, influencia a distribuição de culpa em situações de falhas éticas. A atribuição de responsabilidades varia conforme a complexidade estrutural dos agentes envolvidos: empresas, programadores ou órgãos reguladores. A complexidade arquitetural permite às empresas deslocar a culpa para o sistema de IA, visto como uma entidade autônoma.

“Quando a IA foi retratada com capacidades mentais mais humanas, os participantes estavam mais dispostos a apontar o dedo para o sistema de IA por falhas morais.

(“When AI was portrayed with more human-like mental capacities, participants were more willing to point fingers at the AI system for moral failures.”)— Estudo citado, Pesquisa sobre responsabilidade em IA

Treinamento e otimização

Para sistemas de IA classificados como de alto risco, como os usados em recrutamento, serviços essenciais e justiça, a regulamentação europeia (EU AI Act) demandas rigorosos frameworks de gestão de risco e qualidade durante todo o ciclo de vida do sistema. Isso inclui requisitos técnicos, supervisão humana e avaliações de impacto sobre direitos fundamentais. A adequação desses processos impacta diretamente a confiança no sistema e reduz a margem para scapegoating.

“Usuários (implentadores) de sistemas de IA de alto risco têm algumas obrigações, embora menores do que os provedores (desenvolvedores).”

(“Users (deployers) of high-risk AI systems have some obligations, though less than providers (developers).”)— EU AI Act, Regulamentação Europeia

Resultados e métricas

Estudos mostram que, apesar da humanização do modelo aumentar a culpa atribuída à IA, a carga final de responsabilidade recai predominantemente sobre os programadores e equipes técnicas. Organismos reguladores mantêm níveis estáveis de responsabilidade. A métrica essencial para reduzir riscos está na implementação de sistemas de gerenciamento de qualidade completos, cobrindo design, testes, monitoramento e documentação detalhada.

“A IA recebeu consistentemente uma porcentagem menor da culpa em comparação com agentes humanos, sendo os programadores ou equipes responsáveis pela maior carga de culpa.”

(“Across all scenarios, AI consistently received a smaller percentage of blame compared to human agents, and the AI programmer or the AI team shouldered the heaviest blame burden.”)— Estudo citado, Pesquisa sobre responsabilidade em IA

Este cenário evidencia a necessidade de maior educação dos usuários finais sobre as capacidades e limitações das ferramentas de IA, além do desenvolvimento de sistemas pessoais e organizacionais para teste, validação e documentação das decisões apoiadas por IA. A transparência e o monitoramento contínuo são essenciais para mitigar riscos e garantir a responsabilização adequada nas aplicações práticas de machine learning e deep learning.

Fonte: (Towards Data Science – AI, ML & Deep Learning)