São Paulo — InkDesign News —

Pesquisadores da Universidade da Califórnia, Riverside, desenvolveram um modelo de deep learning que utiliza machine learning para detectar vídeos manipulados, superando limitações anteriores que focavam apenas em alterações faciais.

Contexto da pesquisa

No contexto atual da desinformação digital, vídeos manipulados podem causar danos significativos. A colaboração entre a UC Riverside e cientistas do Google resultou na criação do UNITE, um modelo capaz de identificar vídeos falsificados, independentemente de manipulações faciais.

Método proposto

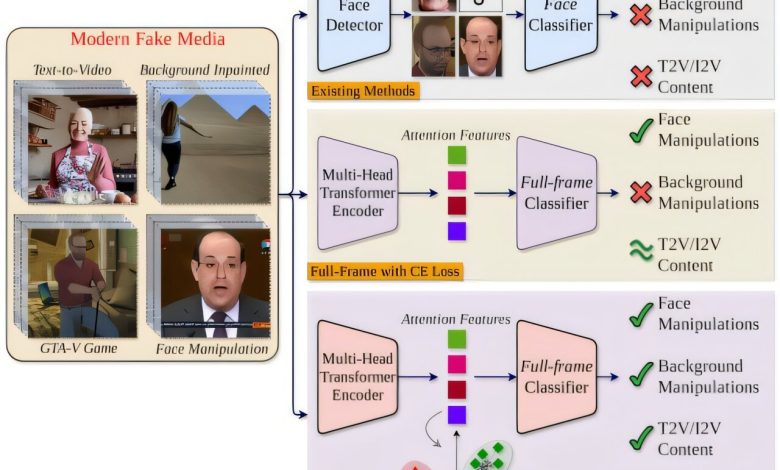

O sistema denominado UNITE (Universal Network for Identifying Tampered and synthEtic videos) utiliza um modelo de deep learning baseado em transformadores. Esse modelo examina não só rostos, mas também os quadros completos dos vídeos, considerando padrões de movimento e fundos. Isso o torna um dos primeiros detectores de vídeos sintéticos que não depende de conteúdo facial. A abordagem emprega um método de treinamento novador chamado “attention-diversity loss”, que força o sistema a monitorar múltiplas regiões visuais em cada quadro.

Resultados e impacto

O UNITE é projetado para detectar inconsistências sutis espaciais e temporais que sistemas anteriores frequentemente ignoravam. Ele foi treinado em grandes conjuntos de dados fornecidos pela equipe do Google, ampliando sua capacidade de identificar conteúdos sintéticos diversos. Segundo Rohit Kundu, “É um modelo que lida com todos esses cenários” (“It’s one model that handles all these scenarios”), demonstrando sua versatilidade em flagrar uma ampla gama de forgeries, desde trocas faciais simples até vídeos gerados inteiramente por IA.

A pesquisa foi apresentada na Conferência de Visão Computacional e Padrões de Reconhecimento (CVPR) de 2025, e o artigo completo pode ser consultado no arXiv (DOI: 10.48550/arxiv.2412.12278).

Com a crescente acessibilidade de ferramentas de geração de vídeo, UNITE poderia ser crucial para plataformas de mídia social e verificadores de fatos, ajudando a mitigar a proliferação de desinformação. Além disso, Kundu observou que “as pessoas merecem saber se o que estão vendo é real” (“People deserve to know whether what they’re seeing is real”).

Fonte: (TechXplore – Machine Learning & AI)