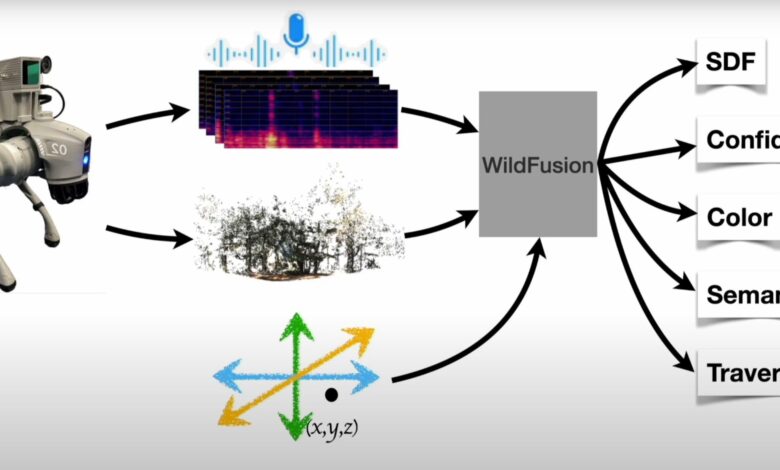

Em um avanço significativo no campo de machine learning, pesquisadores da Universidade Duke desenvolveram o WildFusion, um framework que integra múltiplas modalidades sensoriais para dotar robôs de uma percepção semelhante à humana, facilitando a navegação em terrenos complexos.

Contexto da pesquisa

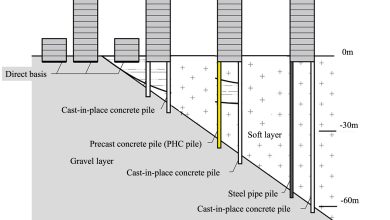

A fusão de dados sensoriais é um dos desafios centrais na robótica atual. Tradicionalmente, robôs dependem fortemente de informações visuais, como câmeras ou LiDAR. No entanto, ambientes naturais, como florestas, apresentam desafios únicos devido à sua complexidade e imprevisibilidade.

Método proposto

O WildFusion combina visão, vibrações e toque em uma abordagem que utiliza sensores RGB, LiDAR, microfones de contato e sensores táteis. O modelo se baseia em representações neuronais implícitas, permitindo que o robô modele superfícies e características de forma contínua, ao contrário de métodos que tratam o ambiente como um conjunto de pontos discretos. Essa integração de dados é processada por um modelo de deep learning, permitindo decisões mais informadas mesmo quando a visão é obstruída.

“WildFusion abre um novo capítulo na navegação robótica e mapeamento 3D.

(“WildFusion opens a new chapter in robotic navigation and 3D mapping.”)— Boyuan Chen, Professor Assistente, Universidade Duke

Resultados e impacto

O WildFusion foi testado com sucesso no Eno River State Park, onde um robô equipado conseguiu navegar por florestas densas e terrenos irregulares. A pesquisa demonstrou que a fusão de dados sensoriais melhorou significativamente a capacidade de previsão de navegabilidade do robô. Em situações de dados escassos ou ruidosos, a abordagem multimodal permitiu que o robô “preenchesse as lacunas”, semelhante à percepção humana.

“Esses testes em condições reais comprovaram a capacidade notável do WildFusion em prever a navegabilidade, melhorando a tomada de decisão segura do robô em terrenos desafiadores.”

(“These real-world tests proved WildFusion’s remarkable ability to accurately predict traversability, significantly improving the robot’s decision-making on safe paths through challenging terrain.”)— Yanbaihui Liu, Estudante de Doutorado, Universidade Duke

Considerando o futuro, a equipe planeja incorporar sensores adicionais, como detectores de temperatura e umidade, ampliando ainda mais as capacidades do sistema WildFusion. As potencialidades incluem aplicações em resposta a desastres e exploração autônoma em cenários imprevisíveis.

Fonte: (TechXplore – Machine Learning & AI)