São Paulo — InkDesign News — Neste artigo, abordamos como a integração de machine learning e algoritmos de busca pela recuperação de informações, conhecidos como RAG (Retrieval-Augmented Generation), está transformando a maneira como interagimos com grandes volumes de dados textuais.

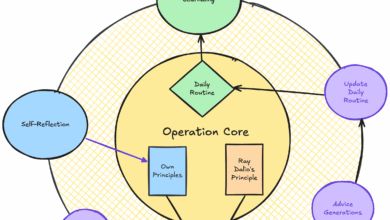

Arquitetura de modelo

O pipeline RAG combina embedding models e large language models (LLMs) para gerar respostas contextualmente relevantes. Essa abordagem envolve a leitura de documentos, fragmentação em partes menores e a transformação dessas partes em vetores significativos.

“Para que LLMs possam lidar com qualquer texto, ele deve estar na forma de um vetor.”

(“For LLMs to handle any text, it must be in the form of a vector.”)— Autor Desconhecido, Estudo sobre RAG

A eficácia da técnica depende de modelos de embedding como BERT e GPT, capazes de mapear palavras e frases em espaços vetoriais de alta dimensionalidade. A distância entre esses vetores revela a similaridade semântica entre os textos.

Treinamento e otimização

O processo de otimização para a criação de embeddings é crucial. Modelos como Word2Vec e GloVe separam palavras de acordo com seu contexto, mas modelos contextualizados, como BERT, são mais eficientes ao lidar com significados diversos em diferentes situações.

Além disso, a utilização de Approximate Nearest Neighbor (ANN) permite acelerar a busca pelas informações mais relevantes, tornando a experiência do usuário significativamente mais rápida.

“Calculamos a similaridade cosine entre os embeddings da consulta do usuário e a base de conhecimento.”

(“By calculating the cosine similarity between the user’s query embeddings and the knowledge base embeddings.”)— Autor Desconhecido, Estudo sobre RAG

Este método garante que os documentos mais pertinentes sejam recuperados com precisão, permitindo um acesso ágil a informações que atendem a solicitações específicas.

Resultados e métricas

A medição de eficácia em sistemas RAG envolve a comparação das pontuações de similaridade cosine. A pontuação varia de 1 a -1, onde 1 significa semântica idêntica e -1, oposta.

Com a implementação de parâmetros de busca, é possível explorar diferentes níveis de profundidade na busca de informações relevantes. Em testes, variáveis como o tamanho dos chunks e a sobreposição geraram resultados distintos nas respostas fornecidas pelo assistente.

“Parâmetros desempenham um papel crucial em obter bons resultados de um pipeline RAG.”

(“Parameters play a crucial role in getting good results from a RAG pipeline.”)— Autor Desconhecido, Estudo sobre RAG

Na prática, essa tecnologia tem mostrado grande potencial em aplicações que vão desde chatbots até sistemas de busca avançados em bases de dados, melhorando a interação e a satisfação do usuário.

Próximos passos

O futuro da RAG parece promissor, com a possibilidade de aperfeiçoamento contínuo nos algoritmos de busca e na geração de respostas. A integração com novas técnicas de deep learning pode expandir ainda mais suas aplicações em setores como educação, saúde e atendimento ao cliente.

Fonte: (Towards Data Science – AI, ML & Deep Learning)