PySpark e Snowflake otimizam feature engineering para modelagem

São Paulo — InkDesign News —

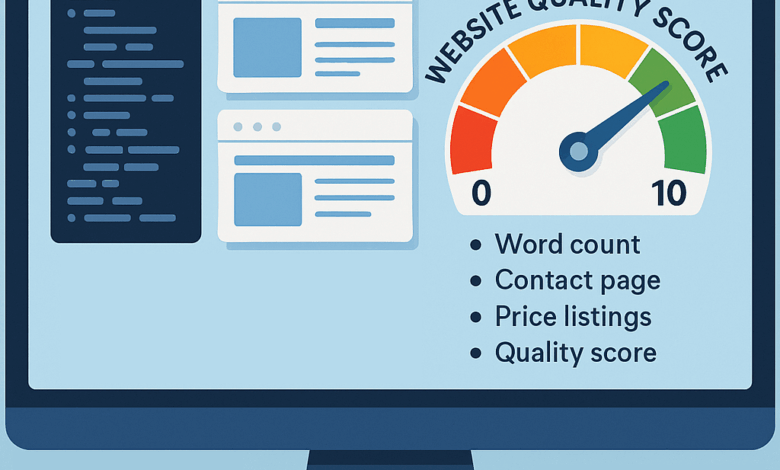

Um novo pipeline de machine learning surge para avaliar automaticamente a qualidade de sites comerciais em múltiplos países, atribuindo um escore de qualidade que sinaliza a maturidade digital e ajuda na seleção de parceiros comerciais de forma escalável.

Arquitetura de modelo

O processo começa com a coleta de milhares de URLs comerciais armazenadas em data warehouses como Snowflake, abrangendo diversas regiões como Brasil, Argentina e Jamaica. Uma abordagem assíncrona em Python utiliza resolução paralela de requisições HTTP, alternando entre agentes de usuário reais para evitar bloqueios básicos. O conteúdo HTML bruto é salvo para posterior análise.

Em seguida, o processamento do conteúdo HTML ocorre via PySpark usando a engine Snowpark da Snowflake, o que permite escalabilidade no cálculo de feature sets a partir de dados massivos. Um User-Defined Function (UDF) é implementado para extrair métricas estruturais e textuais: contagem de palavras, tamanho do título da página, número de links, imagens, scripts e presença de páginas como “contato” e “sobre”. A identificação de ofertas de produtos é feita via expressões regulares para detectar padrões de preços locais.

“Este scraper apenas contabiliza palavras, links, imagens, scripts e flags simples de ‘contato/sobre/preço’, não extrai nem armazena dados privados ou sensíveis.”

(“This scraper only counts words, links, images, scripts and simple “contact/about/price” flags, it does not extract or store any private or sensitive data.”)— Lucas Braga, Desenvolvedor do Projeto

Treinamento e otimização

Os dados processados resultam em um dicionário de atributos para cada site, onde são aplicadas regras de pontuação que atribuem pesos a diferentes elementos, como presença de conteúdo textual rico, páginas institucionais e listagens de preços. O escore final varia de 0 a 10, refletindo a qualidade geral do site.

Essa abordagem de feature engineering orientada por regras atua como um forte sinal para modelos preditivos como regressão logística, florestas aleatórias e redes neurais profundas, complementando métricas tradicionais como volume de vendas e avaliações de usuários.

“Uma vez computado e armazenado, o escore de qualidade do website torna-se uma entrada direta para praticamente qualquer modelo preditivo.”

(“Once computed and stored, the website quality score becomes a straightforward input to virtually any predictive model.”)— Lucas Braga, Desenvolvedor do Projeto

Resultados e métricas

O pipeline provê resultados robustos e escaláveis, reduzindo a necessidade de interações manuais e permitindo a análise quantitativa da maturidade digital de milhares de comerciantes. A combinação dos recursos extraídos e do modelo simplificado de pontuação permite filtrar eficientemente candidatos com maior profissionalismo online.

Além das métricas internas, o sistema prioriza boas práticas éticas na coleta de dados, como limitação da concorrência das requisições, pausas entre lotes e política de retenção de dados para garantir respeito à privacidade e ao desempenho dos sites.

“Use concorrência modesta e pausas entre lotes para evitar sobrecarregar os servidores de um mesmo domínio.”

(“Throttle responsibly: use modest concurrency (e.g. CONCURRENT_REQUESTS ≤ 10), insert small pauses between batches, and avoid hammering the same domain.”)— Lucas Braga, Desenvolvedor do Projeto

Esse modelo baseado em regras em PySpark, aliado à flexibilidade de configuração por país, amplia a aplicabilidade a diferentes idiomas e convenções locais, tornando-se um recurso útil para empresas que atuam em múltiplos mercados.

O próximo passo envolve integrar esses escores de qualidade em fluxos de machine learning para automação de recomendações e expandir a análise a múltiplas camadas de atributos digitais utilizando técnicas de deep learning.

Fonte: (Towards Data Science – AI, ML & Deep Learning)