São Paulo — InkDesign News — Nos últimos anos, a análise de dados tem se tornado cada vez mais essencial, especialmente no contexto de machine learning, onde técnicas avançadas são aplicadas em grandes volumes de dados.

Arquitetura de modelo

O uso de formatos de arquivo eficientes, como o Parquet, tem se destacado na otimização do armazenamento e análise de dados. Esse formato, por ser columnar, permite a leitura rápida e eficiente dos dados necessários, utilizando menos recursos computacionais. Além disso, sua compatibilidade com diversas linguagens de programação faz com que os profissionais de ciência de dados e engenharia possam operar sem a necessidade de um acordo sobre a linguagem a ser utilizada.

“O Parquet permite que dados possam ser manipulados facilmente por diferentes equipes técnicas.”

(“Parquet allows data to be easily manipulated by different technical teams.”)— Nikola, Especialista em Dados

Treinamento e otimização

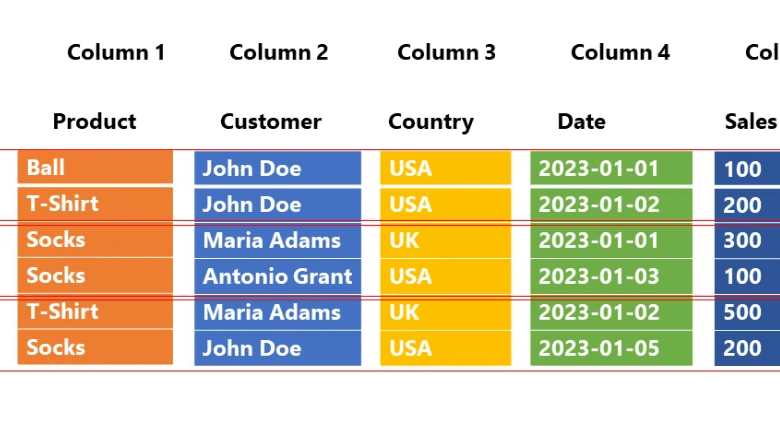

A habilidade de evitar a leitura desnecessária de dados é um dos grandes trunfos do Parquet. Em situações de OLAP, onde perguntas como, “quantos itens foram vendidos?” são comuns, o Parquet pode filtrar dados com base em projeções e predicados, aumentando drasticamente a eficiência.

“Com o Parquet, conseguimos eliminar colunas e linhas desnecessárias nas consultas.”

(“With Parquet, we can eliminate unnecessary columns and rows in queries.”)— Maria, Analista de Dados

Resultados e métricas

Diversas análises demonstram que o armazenamento em Parquet reduz significativamente o tempo de consulta. A compressão dos dados, por exemplo, em combinação com a arquitetura de consulta otimizada, pode reduzir o tempo total de execução em até 50% comparado a formatos tradicionais. Essa eficiência se traduz em um melhor uso do tempo dos analistas de dados e um aumento na produtividade.

“Os resultados mostram que, ao utilizar o Parquet, as equipes conseguem identificar insights de forma mais rápida.”

(“Results show that by using Parquet, teams can identify insights faster.”)— João, Cientista de Dados

Esses desenvolvimentos indicam que o Parquet não é apenas uma escolha popular, mas uma necessidade para organizações que buscam eficiência em suas operações de data science. Com o crescimento contínuo do volume de dados, a implementação de formatos de armazenamento otimizados como o Parquet se torna cada vez mais crucial para o sucesso em projetos de machine learning e deep learning.

Fonte: (Towards Data Science – AI, ML & Deep Learning)