OTPO melhora alinhamento de LLM com nova modelagem inteligente

São Paulo — InkDesign News — Um novo algoritmo chamado OTPO está mudando a forma como modelos de machine learning são alinhados às preferências humanas, oferecendo uma abordagem mais inteligente para o treinamento de assistentes de IA.

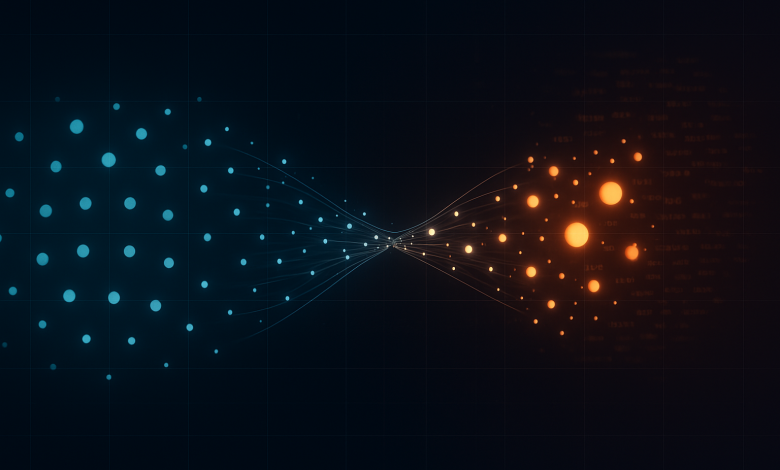

Arquitetura de modelo

O treinamento de modelos de aprendizado profundo, como os LLMs (Modelos de Linguagem de Grande Escala), tradicionalmente utiliza a técnica de Direct Preference Optimization (DPO). No entanto, o DPO apresenta limitações significativas, especialmente no que se refere ao tratamento equitativo dos tokens. Essa abordagem não considera a importância semântica de palavras individuais na resposta.

“A capital da França é Paris, e é uma cidade linda com muitas atrações.

(“The capital of France is Paris, and it’s a beautiful city with many attractions.”)— Usuário, interação com LLM

Treinamento e otimização

O algoritmo OTPO (Optimal Transport-Based Token Weighting) propõe uma solução inovadora ao abordar a questão do peso dos tokens. Através da teoria de transporte ótimo, OTPO reavalia como as mudanças semânticas entre os tokens devem afetar a maneira como as respostas são otimizadas. Esse novo paradigma permite que os tokens críticos, como “Paris”, recebam mais peso na otimização em comparação com palavras menos significativas.

“A transformação semântica entre os tokens é tratada como um problema de transporte ótimo.

(“OTPO views preference optimization as a transport problem.”)— Pesquisador, equipe de desenvolvimento do OTPO

Resultados e métricas

Na fase de testes, o OTPO demonstrou um aumento de aproximadamente 8,5% na eficiência de tarefas de resumo quando comparado a outras metodologias. Além do mais, ao ser aplicado em conjuntos de dados com modelos menores como o Llama-3–8B, o OTPO gerou respostas mais curtas e de maior qualidade, minimizando a tendência à verbosidade encontrada em outras abordagens.

“Resultados mistos foram observados em diferentes conjuntos de dados, demonstrando que mais pesquisas são necessárias para estabilizar os ganhos em acurácia.

(“Testing was not exhaustive enough to present the accuracy number across the domain.”)— Analista, pesquisa de desempenho do OTPO

As tecnologias de IA estão em constante evolução, e o OTPO representa um passo importante na otimização de modelos de linguagem, possibilitando aplicações mais precisas e alinhadas com as preferências humanas. A aplicação prática e o aprofundamento na pesquisa prometem proporcionar uma interface de IA mais intuitiva e confiável.

Fonte: (Towards Data Science – AI, ML & Deep Learning)