Com o avanço constante em machine learning, a necessidade de infraestrutura de IA eficiente se torna cada vez mais crítica, especialmente para modelos generativos como o ChatGPT-4. Pesquisadores da KAIST propuseram uma tecnologia de unidade de processamento neural (NPU) que promete melhorar significativamente o desempenho desses sistemas.

Contexto da pesquisa

A pesquisa, liderada pelo professor Jongse Park da KAIST School of Computing, em colaboração com a HyperAccel Inc., visa resolver os desafios enfrentados pelos centros de dados de IA, que exigem alto bandwidth e capacidade de memória para suportar modelos complexos de generative AI.

Método proposto

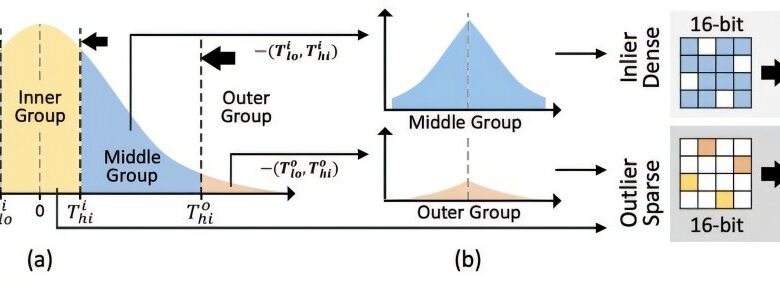

A equipe desenvolveu a Oaken, uma arquitetura de NPU com um algoritmo de quantização que integra três componentes principais: quantização híbrida online-offline baseada em limiar, quantização de deslocamento em grupos e codificação densa-esparsa fundida. Isso permite a realização de processos de inferência com menor consumo de energia e redução significativa nas necessidades de memória, especialmente no que se refere ao cache KV, que é uma parte crítica do uso de memória nesses sistemas.

Resultados e impacto

Os resultados indicam uma melhora média de mais de 60% no desempenho de inferência, ao mesmo tempo em que consome aproximadamente 44% menos energia em comparação com as GPUs mais recentes. O estudante de doutorado Minsu Kim e o Dr. Seongmin Hong apresentaram os resultados na ISCA 2025, realizada em Tóquio. A pesquisa destaca a importância de um design integrado de semicondutores de IA e software de sistema de IA, fundamentais para a infraestrutura de IA moderna.

“Esta pesquisa, através do trabalho conjunto com a HyperAccel Inc., encontrou uma solução em algoritmos de leveza de inferência de generative AI e conseguiu desenvolver uma tecnologia central de NPU que pode resolver o problema de memória. Através desta tecnologia, implementamos uma NPU com mais de 60% de desempenho melhorado em comparação com as GPUs mais recentes.”

(“This research, through joint work with HyperAccel Inc., found a solution in generative AI inference light-weighting algorithms and succeeded in developing a core NPU technology that can solve the memory problem. Through this technology, we implemented an NPU with over 60% improved performance compared to the latest GPUs.”)— Jongse Park, Professor, KAIST

As implicações dessa pesquisa são profundas, com potencial para transformar não apenas data centers em nuvem de IA, mas também a implementação de IA em ambientes adaptativos e dinâmicos, como a chamada IA agentiva. Esta tecnologia pode levar a uma redução significativa nos custos operacionais e proporcionar maior eficiência em soluções de IA.

Fonte: (TechXplore – Machine Learning & AI)