Novo modelo matemático aprimora transfer learning em redes neurais

Radboud, Países Baixos — InkDesign News — Uma nova metodologia matemática desenvolvida por pesquisadores do Donders Institute for Neuroscience, em colaboração com instituições italianas, promete avançar o uso de machine learning em cenários de dados limitados por meio da análise da eficácia do transfer learning em redes neurais.

Contexto da pesquisa

O treinamento de sistemas de inteligência artificial (IA) usualmente requer grandes volumes de dados. Para tarefas como reconhecimento de imagens, a eficácia depende da quantidade e diversidade dos exemplos utilizados durante o aprendizado. Contudo, áreas especializadas — como diagnóstico médico por ultrassom — enfrentam escassez de dados, aumentando o risco de overfitting e resultado em falso-positivos e falso-negativos elevados. O transfer learning surge como alternativa, transferindo conhecimento de uma rede “fonte” treinada em larga escala para uma rede “alvo” que opera com poucos dados.

Método proposto

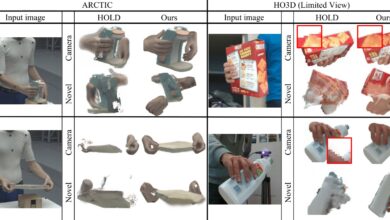

Os pesquisadores focaram no modelo mais simples de transfer learning, redes neurais totalmente conectadas com uma única camada oculta. A novidade está na combinação do método analítico “Kernel Renormalization” com a formalidade clássica “Franz-Parisi” da teoria de Spin Glasses. Essa fusão permite trabalhar diretamente com bases de dados reais, superando limitações de abordagens estatísticas e aproximações.

“Nosso novo método pode prever direta e acuradamente a eficácia da generalização do alvo ao adotar o conhecimento da rede fonte.”

(“Our new method can directly and accurately predict how effective the target network will be in generalizing data when it adopts knowledge from the source network.”)— Alessandro Ingrosso, Pesquisador, Donders Institute for Neuroscience

Resultados e impacto

A abordagem matemática traz avanços para prever o desempenho da rede neural alvo ao utilizar transfer learning, especialmente na configuração proporcional, onde a dimensão da rede e o tamanho do conjunto de dados crescem simultaneamente. Esse resultado representa uma contribuição significativa para o treinamento de IA em domínios com poucas amostras disponíveis, como diagnóstico médico, viabilizando modelos com melhor capacidade de generalização e menor incidência de erros.

Os experimentos adotaram datasets reais e métricas clássicas de acurácia para validar a predição da técnica, reforçando sua aplicabilidade fora do ambiente controlado das simulações. O estudo abre caminho para aplicações em outras áreas especializadas que enfrentam restrições similares de dados.

Próximos passos incluem testes em arquiteturas mais complexas e em problemas de maior escala, ampliando a utilidade da teoria. Esta pesquisa está documentada no artigo “Statistical Mechanics of Transfer Learning in Fully Connected Networks in the Proportional Limit”, disponível em Physical Review Letters e no repositório arXiv.

Para explorar mais sobre machine learning, visite nossas tags Machine Learning e Deep Learning.

Fonte: (TechXplore – Machine Learning & AI)