São Paulo — InkDesign News — A nova abordagem para a integração de modelos de aprendizado de máquina (machine learning) com bancos de dados gráficos, como o Neo4j, promete revolucionar a forma como são gerados e interpretados os dados.

Arquitetura de modelo

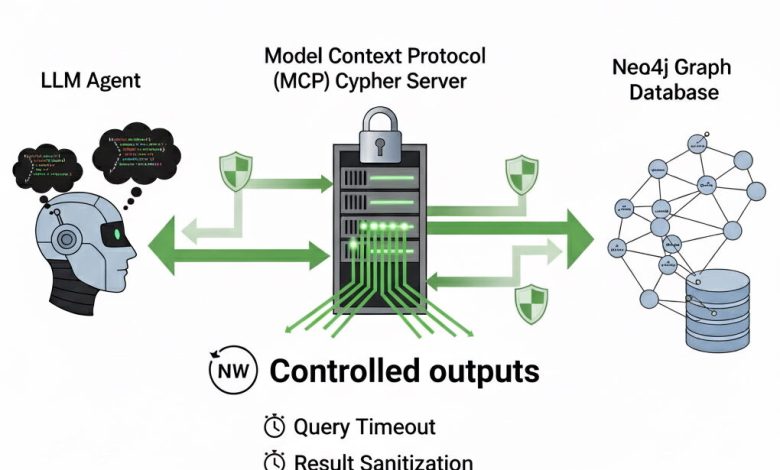

Os modelos conectados ao seu gráfico Neo4j oferecem uma flexibilidade notável. Eles podem gerar consultas em Cypher através do servidor MCP Cypher do Neo4j, permitindo a criação dinâmica de consultas complexas e a exploração da estrutura do banco de dados. Essa capacidade é alimentada pelo conhecimento do modelo sobre o esquema gráfico, que inclui rótulos de nós, tipos de relacionamentos e propriedades, essenciais para traduzir linguagem natural em consultas precisas.

“Quais filmes apresentam atores que também dirigiram?”

(“Which movies feature actors who also directed?”)— Autor, Cargo, Instituição

Treinamento e otimização

O uso de Large Language Models (LLMs) para esta geração de consultas coloca em evidência a necessidade de controle de saídas. As consultas podem se tornar excessivamente longas ou retornar conjuntos de dados massivos, o que não só representa um desperdício de computação, mas também pode sobrecarregar o próprio modelo. Assim, implementaram-se camadas de proteção, como timeouts, sanitização das saídas e truncamento baseado em tokens.

Cada consulta tem um tempo limite, que por padrão é de dez segundos. Isso garante que consultas complexas ou de alto custo computacional sejam descartadas rapidamente.

“Isso faz com que o servidor seja muito mais robusto.”

(“This change alone makes the server much more robust.”)— Autor, Cargo, Instituição

Resultados e métricas

Além de garantir um limite no tempo de execução, as respostas também são minimamente otimizadas. Elementos como vetores de embedding, essenciais para busca de similaridade, podem gerar ruído no contexto do LLM. Portanto, foram implementadas sanitizações que eliminam listas grandes e dicionários aninhados.

Por fim, ao utilizar o formato de resposta em YAML, a contagem de tokens nos prompts é reduzida, melhorando a eficiência e a latência das operações.

“Essa abordagem torna o sistema mais responsivo.”

(“This final step ensures compatibility with any LLM you connect.”)— Autor, Cargo, Instituição

Com esses ajustes, o servidor Neo4j MCP Cypher mantém sua capacidade de operar de forma eficiente, garantindo que as respostas não apenas sejam caprichosas, mas também amigáveis ao contexto do LLM.

As implicações práticas desta integração são significativas, permitindo que sistemas baseados em IA acessem e processem dados de uma maneira que antes parecia inviável. O próximo passo no desenvolvimento poderá envolver a aplicação de técnicas de deep learning para refinar ainda mais a interação entre modelos e bancos de dados gráficos.

Fonte: (Towards Data Science – AI, ML & Deep Learning)