São Paulo — InkDesign News — A adoção de modelos bayesianos em machine learning enfrenta desafios significativos, mas novas técnicas de Inferência Variacional Estocástica (SVI) utilizando múltiplas GPUs prometem acelerar processos em até 10.000 vezes.

Arquitetura de modelo

Os modelos bayesianos são frequentemente utilizados em cenários onde a incorporação de conhecimento prévio e quantificação de incertezas são desejáveis. Entretanto, as abordagens tradicionais, como o método de Monte Carlo por Cadeia de Markov (MCMC), apresentam uma desvantagem significativa: sua lentidão quando aplicadas a espaços de alta dimensão. Um exemplo do modelo base configura-se como:

$$log(textrm{Demanda}_{it})= beta_i log(textrm{Preço})_{it} +gamma_{c(i),t} + delta_i + epsilon_{it}$$

onde $textrm{Unidades Vendidas}_{it} sim textrm{Poisson}(textrm{Demanda}_{it}, sigma_D)$. Essa estrutura hierárquica permite modelar dados de vendas diretamente, evitando as complicações associadas a transformações logarítmicas.

Treinamento e otimização

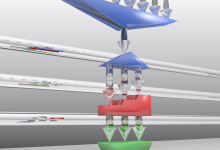

A abordagem SVI reformula a inferência bayesiana como um problema de otimização, minimizando a divergência de Kullback-Leibler entre uma distribuição aproximada e a verdadeira distribuição posterior. O treinamento é realizado em um ambiente otimizado com JAX, que permite computação acelerada por GPU. Ao duplicar dados entre dispositivos e implementar técnicas eficientes de sharding, a velocidade de convergência do SVI pode ser drasticamente aumentada.

“Os métodos bayesianos podem ser aplicados em cenários onde queremos explorar rapidamente muitos modelos”

(“Variational inference is suited to large data sets and scenarios where we want to quickly explore many models.”)— Blei et al., Pesquisador, Universidade

Resultados e métricas

Testes realizados comparando o tempo de otimização ao longo de diferentes tamanhos de dataset mostraram resultados impressionantes. Para um conjunto de dados menor (10.000 produtos e 1,56 milhões de observações), o SVI em 4 GPUs apresentou um tempo de execução de apenas 21 minutos, enquanto o MCMC levaria cerca de 20 horas, sem garantir convergência. Esse ganho em velocidade torna viável a aplicação de modelos bayesianos complexos em grandes conjuntos de dados e pode atingir melhorias de até 10.000 vezes em comparação com os métodos tradicionais.

“Esses resultados indicam que as configurações de múltiplas GPUs são essenciais para estimar modelos bayesianos hierárquicos grandes”

(“These findings demonstrate that multi-GPU setups are essential for estimating large hierarchical Bayesian models.”)— Autor do Estudo, Empresa

A pesquisa sugere que as técnicas demonstradas podem permitir aplicações em áreas como análises de marketing mais granulares e cálculos de risco em instituições financeiras. À medida que novas hardwares emergem, os passos seguintes em pesquisa incluirão a correção da incerteza posterior, abordando necessidades críticas em quantificação de incertezas. O potencial de integração entre mini-batching e computação distribuída também se apresenta como uma área promissora para futuras investigações.

Fonte: (Towards Data Science – AI, ML & Deep Learning)