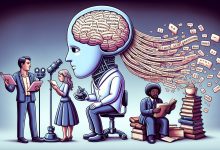

Recentes avanços em machine learning têm permitido o desenvolvimento de modelos cada vez mais sofisticados, incluindo aqueles que combinam linguagem e percepção visual. Esses modelos, conhecidos como MLLMs (multimodal large language models), estão sendo analisados por suas capacidades de raciocínio e sua suscetibilidade a alucinações.

Contexto da pesquisa

Pesquisadores da UC Santa Cruz, Stanford University e UC Santa Barbara realizaram um estudo sobre as alucinações em modelos de raciocínio multimodal. Embora esses sistemas tenham demonstrado consideráveis melhorias em suas habilidades de raciocínio, foi observada uma tendência de gerar saídas que não se baseiam nos dados de entrada. Essa situação é especialmente marcada em modelos como o GPT-4 com Visão e o Google Gemini.

Método proposto

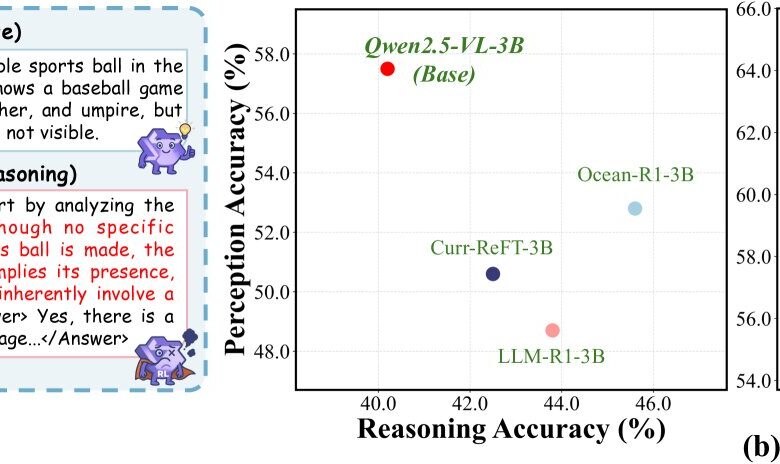

Os cientistas desenvolveram uma nova métrica chamada RH-AUC, que quantifica a precisão da percepção de um modelo em relação ao comprimento do raciocínio. Além disso, introduziram o RH-Bench, um benchmark diagnóstico que avalia a relação entre a habilidade de raciocínio e a propensão a alucinações. Estudos preliminares mostraram que cadeias de raciocínio mais longas resultam em uma maior tendência a alucinações devido à diminuição da atenção em estímulos visuais.

“A análise da atenção demonstra que cadeias de raciocínio mais longas levam a um foco reduzido em entradas visuais, o que contribui para alucinações.”

(“Attention analysis shows that longer reasoning chains lead to reduced focus on visual inputs, which contributes to hallucination.”)— Chengzhi Liu, Pesquisador, UC Santa Cruz

Resultados e impacto

Os resultados coletados indicam que modelos maiores tendem a equilibrar melhor suas capacidades de raciocínio e percepção, sendo essa relação influenciada mais pelos tipos de dados de treinamento do que por seu volume total. Os pesquisadores enfatizam a necessidade de frameworks de avaliação que considerem tanto a qualidade do raciocínio quanto a fidelidade perceptual.

“Essas descobertas ressaltam a importância de frameworks de avaliação que considerem conjuntamente tanto a qualidade do raciocínio quanto a fidelidade perceptual.”

(“These findings underscore the importance of evaluation frameworks that jointly consider both reasoning quality and perceptual fidelity.”)— Zhongxing Xu, Pesquisador, Stanford University

As novas ferramentas avaliativas podem facilitar a identificação de como os modelos multimodais podem ser aprimorados para lidar com problemas complexos de raciocínio, minimizando a incidência de alucinações. Este avanço poderá beneficiar áreas como a criação de conteúdo multimídia e a resolução de problemas em contextos variados.

Fonte: (TechXplore – Machine Learning & AI)