São Paulo — InkDesign News —

Um recente estudo destaca a eficácia de algoritmos personalizados em comparação com modelos de machine learning de última geração, revelando nuances sobre a aplicabilidade de técnicas de deep learning em jogos lógicos.

Arquitetura de modelo

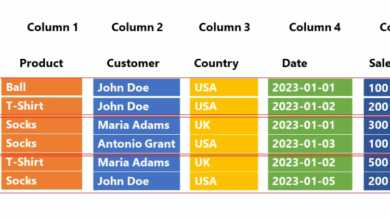

O estudo analisou um algoritmo próprio contra três modelos de large language models (LLMs). O algoritmo foi projetado especificamente para o jogo WORDLE, exigindo dedução lógica precisa. Os LLMs, como o ChatGPT, Gemini e Llama, foram testados em um formato de competição ao longo de 30 dias.

“Vamos supor que estou jogando WORDLE, mas em espanhol. É um jogo em que você deve adivinhar uma palavra de 5 letras em 6 tentativas.”

(“Let’s suppose I’m playing WORDLE, but in Spanish. It’s a game where you have to guess a 5-letter word, and only 5 letters, in 6 attempts.”)— Autor, Data Scientist

Treinamento e otimização

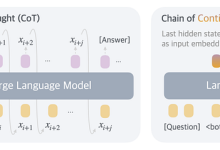

O processo de treinamento dos LLMs envolveu prompts direcionais, detalhando regras e exemplos de como o jogo funciona. A estrutura de feedback foi crucial, fornecendo condições para a geração de novas suposições com base em tentativas anteriores.

“Todas as informações que eu fornecer devem ser usadas para construir sua sugestão.”

(“All the information I give you must be used to build your suggestion.”)— Autor, Data Scientist

Resultados e métricas

A análise dos resultados mostrou que o algoritmo desenvolvido teve um desempenho dominante, ganhando consistentemente em comparação com os LLMs. Enquanto os modelos básicos falharam em gerar qualquer vitória, o modelo ajustado apresentou uma taxa de vitórias constante.

“O modelo de raciocínio dos LLMs proporciona um grande aumento de desempenho nesta tarefa.”

(“The reasoning capability behind LLMs provides a huge boost to performance in this task.”)— Autor, Data Scientist

No entanto, embora os LLMs com capacidade de raciocínio tenham melhorado a precisão e a consistência, o algoritmo especializado ainda demonstrou um leve desempenho superior. O estudo também propõe que, ao implementar LLMs em aplicações do mundo real, é essencial considerar fatores como o tempo de resposta e custo, visto que os modelos de raciocínio demandam mais tempo para gerar uma resposta.

A experiência sugere que as soluções personalizadas ainda têm sua relevância, especialmente em casos onde lógica e raciocínio são cruciais.

Para os próximos passos, investigações adicionais podem expandir a pesquisa sobre as aplicações práticas dos LLMs em contextos mais complexos, além de explorar como adaptar algoritmos existentes para desafios novos.

Fonte: (Towards Data Science – AI, ML & Deep Learning)