São Paulo — InkDesign News — A pesquisa recente da Universidade Estadual da Pensilvânia revela que a eficácia dos anotadores de dados de terceiros em máquinas de aprendizado (machine learning) para interpretar emoções é questionável, destacando a necessidade de revisões nos métodos de rotulação.

Contexto da pesquisa

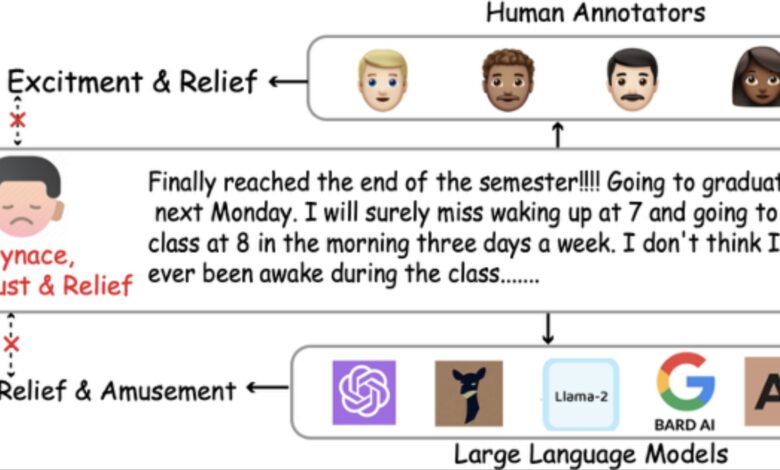

A pesquisa se concentra na acurácia das anotações de emoções feitas por humanos e modelos de linguagem (LLMs), considerando a premissa de que as emoções expressas em textos podem ser corretamente identificadas por terceiros. Pesquisadores da Universidade Estadual da Pensilvânia lideraram um estudo que desafia a suposição de que os anotadores de dados podem inferir de maneira confiável os estados emocionais dos autores apenas a partir de textos.

Método proposto

Para investigar a precisão das anotações de emoções, o estudo utilizou um experimento onde usuários de redes sociais compartilharam suas postagens e rotularam as emoções que diziam expressar. Grupos de anotadores humanos, com características demográficas variadas em relação aos autores, e vários LLMs foram solicitados a rotular as mesmas postagens. A análise foi realizada utilizando métricas como F1 score e testes estatísticos para avaliar a alineação entre emocões reportadas pelos autores e os rótulos de terceiros.

A pergunta que nos motivou a estudar a relação entre emoções auto-relatadas e as interpretações de anotadores de terceiros foi: Até que ponto suas anotações são confiáveis?

(“This question drove us to systematically study the alignment between self-reported (first-party) emotions and the interpretations of third-party annotators, including both humans and LLMs.”)— Jiayi Li, Estudante de doutorado, Universidade Estadual da Pensilvânia

Resultados e impacto

Os resultados i$nferiram uma clara desarmonia entre as emoções relatadas pelos autores e as anotações de terceiros. Analisou-se que anotadores humanos com características demográficas semelhantes aos autores apresentaram maior acerto nas interpretações. Além disso, houve uma melhora significativa, ainda que pequena, nas anotações feitas por LLMs quando estas foram informadas sobre o contexto demográfico dos autores. Isso sugere que fatores demográficos influenciam a capacidade de inferência emocional.

A descoberta mais notável do nosso estudo é a clara desarmonização entre as anotações de terceiros e as emoções auto-relatadas de primeira pessoa, desafiando a suposição de que anotadores podem inferir as emoções alheias com precisão.

(“The most notable finding from our study is the clear misalignment between third-party annotations and first-party self-reported emotions, challenging a common assumption in emotion recognition research.”)— Sarah Rajtmajer, Autora sênior do estudo, Universidade Estadual da Pensilvânia

Os achados deste estudo têm implicações diretas para a anotação de conjuntos de dados textuais utilizados no treinamento de modelos de processamento de linguagem natural (NLP), incluindo LLMs, promovendo a geração de respostas mais precisas em relação às emoções expressas pelos usuários.

De acordo com a equipe de pesquisa, “nossa investigação demonstra a importância de delinear corretamente a perspectiva emocional que está sendo capturada, seja a do autor ou a de um observador.” ( “Our study highlights the need for researchers and developers to be precise about whose emotional perspective they are capturing—the author’s or an observer’s.” ). Isso é especialmente relevante em aplicações como suporte à saúde mental e sistemas de diálogo empáticos, onde é crucial entender o estado emocional do autor.

Para futuras pesquisas, há um interesse em desenvolver modelos de emoção mais nuançados e centrados no usuário, que vão além das categorias emocionais básicas tradicionais.

Fonte: (TechXplore – Machine Learning & AI)