Modelos de IA dificultam identificação de fotos falsas e exigem novas regras

Contexto da pesquisa

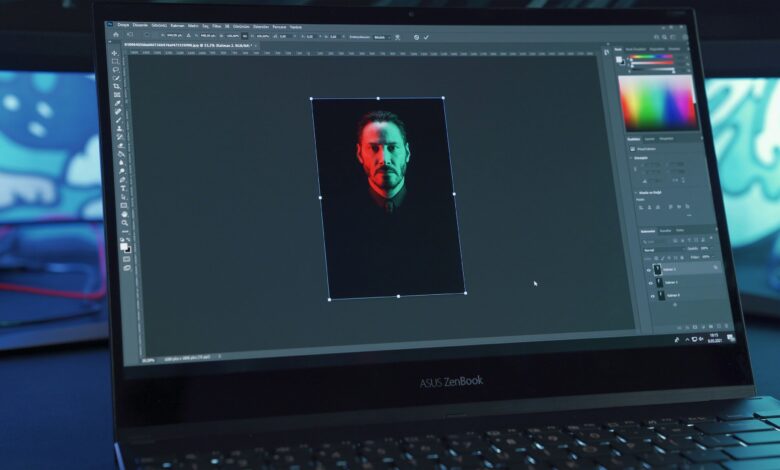

São Paulo — InkDesign News — Pesquisas recentes destacam os desafios éticos e técnicos relacionados ao uso de machine learning e inteligência artificial (AI) na manipulação e geração de imagens. Com o avanço das tecnologias generativas, como modelos baseados em Redes Neurais Convolucionais (CNN) e Modelos de Linguagem de Grande Escala (LLM), tornou-se cada vez mais difícil distinguir fotos reais de imagens fabricadas ou alteradas digitalmente, impactando a confiança em mídias visuais.

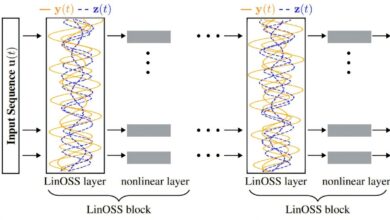

Método proposto

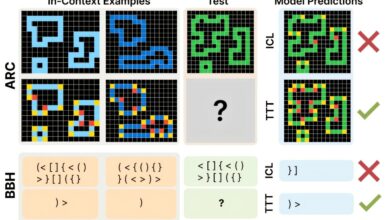

Para enfrentar esse problema, pesquisadores da Universidade de Witwatersrand, África do Sul, sugerem a criação de um sistema de categorização clara das imagens manipuladas, classificadas em cinco categorias: Correção (C), Realce (E), Manipulação do Corpo (B), Manipulação de Objetos (O) e Geração (G). Esse sistema visa documentar as alterações feitas, desde ajustes automáticos de cor até imagens inteiramente geradas por IA, como aquelas produzidas por GANs (Generative Adversarial Networks).

“Parte da solução para este problema social exige duas ações simples e claras. Primeiro, declarar que a manipulação da foto ocorreu. Segundo, divulgar que tipo de manipulação foi realizada.”

(“Part of the solution to this social problem demands two simple and clear actions. First, declare that photo manipulation has taken place. Second, disclose what kind of photo manipulation was carried out.”)— Prof. Helen Nissenbaum, Universidade de Witwatersrand

O método propõe que softwares responsáveis pela edição de fotos possam automaticamente identificar e registrar essas categorias na metadata da imagem, aumentando a transparência e a confiabilidade na divulgação. Esse sistema pode ser integrado a plataformas digitais para facilitar a adesão em mídias sociais e veículos jornalísticos.

Resultados e impacto

A proposta ainda está em estágio conceitual, mas seu potencial para elevar os padrões éticos no uso de IA em imagens é significativo. A rotulagem explícita pode contribuir para mitigar os impactos negativos das deepfakes e notícias falsas, reforçando a confiança pública na mídia visual. O método também considera métricas de avaliação da manipulação, promovendo um padrão internacional possível de ser adotado em pesquisas e aplicações comerciais.

“A aplicação automática dessas categorias poderia reduzir erros humanos e garantir consistência na marcação das imagens, promovendo uma base ética e transparente.”

(“Responsible photo manipulation software may automatically indicate to users the class of photo manipulation carried out, possibly reducing human error and ensuring consistent application.”)— Prof. Helen Nissenbaum, Universidade de Witwatersrand

Próximos passos incluem o desenvolvimento de algoritmos que detectem e classifiquem automaticamente as manipulações, bem como parcerias com desenvolvedores de software, veículos de mídia e formuladores de políticas para implementar esse padrão de maneira efetiva. A iniciativa terá impacto direto em áreas como jornalismo, segurança digital e verificação de fatos.

Leia mais sobre machine learning e deep learning.

Fonte: (TechXplore – Machine Learning & AI)