Avanços em Algoritmos de Decodificação Acelerada nas AI

Machine learning tem se mostrado uma área promissora nas últimas décadas, especialmente com o desenvolvimento de grandes modelos de linguagem (LLMs) que impulsionam a inteligência artificial (AI) contemporânea. Pesquisas recentes apresentam novas técnicas que prometem aumentar a eficiência desses sistemas.

Contexto da pesquisa

Recentemente, no International Conference on Machine Learning (ICML), realizado em Vancouver, Canadá, cientistas do Weizmann Institute of Science e Intel Labs divulgaram um conjunto de algoritmos que buscam remover as barreiras entre modelos de AI de diferentes empresas. A pesquisa apresenta uma solução inovadora para problemas relacionados à lentidão e ao alto consumo de poder computacional das LLMs.

Método proposto

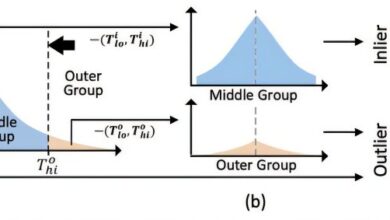

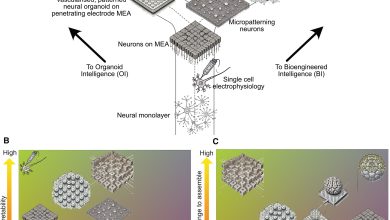

O estudo introduz um conceito conhecido como “decodificação especulativa”, onde um modelo menor e mais rápido faz uma primeira suposição ao responder a uma consulta, enquanto um modelo maior, contudo, mais lento, revisa e corrige a resposta. O principal desafio dessa abordagem era a necessidade de que ambos os modelos “falassem” a mesma linguagem. As novas abordagens criadas pelos pesquisadores permitem que qualquer modelo pequeno seja emparelhado com um grande, superando esse obstáculo. Isso é feito através de dois algoritmos principais: um que traduz a saída de um LLM para um formato compartilhado e outro que incentiva o uso de tokens com significados equivalentes entre diferentes modelos.

“No início, estávamos preocupados que muita informação seria ‘perdida na tradução’ e que diferentes modelos não conseguiriam colaborar efetivamente”, diz Timor.

(“At first, we worried that too much information would be ‘lost in translation’ and that different models wouldn’t be able to collaborate effectively.”)— Nadav Timor, Doutorando, Weizmann Institute of Science

Resultados e impacto

Os resultados indicam que as novas técnicas podem acelerar o desempenho das LLMs em até 2,8 vezes, resultando em economias significativas nos custos de processamento. O impacto dessa pesquisa é significativo, uma vez que a colaboração entre diferentes modelos pode levar a aplicativos mais rápidos e inteligentes, especialmente em dispositivos de borda, como drones e carros autônomos.

“Resolvemos uma ineficiência central na AI generativa… Esses são ferramentas práticas que já estão ajudando desenvolvedores a criar aplicações mais rápidas e inteligentes”, afirma Oren Pereg.

(“We have solved a core inefficiency in generative AI… This isn’t just a theoretical improvement; these are practical tools that are already helping developers build faster and smarter applications.”)— Oren Pereg, Pesquisador Sênior, Intel Labs

As aplicações dessas novas tecnologias são amplas e incluem potencial para melhorar a segurança e a eficiência em sistemas que operam com recursos limitados. A equipe já disponibilizou os algoritmos na plataforma open-source Hugging Face Transformers, permitindo que desenvolvedores em todo o mundo acessem essas inovações.

Fonte: (TechXplore – Machine Learning & AI)