São Paulo — InkDesign News — Um estudo recente destaca que escolhas de hardware e a quantidade desse hardware durante o treinamento de modelos de inteligência artificial (IA) impactam significativamente o consumo de recursos. Em particular, o tempo de treinamento também se mostrou crucial para otimizar a eficiência energética em “deep learning”.

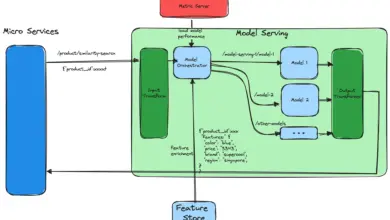

Arquitetura de modelo

O trabalho analisou modelos históricos e de ponta da IA, com foco nas opções de hardware e arquitetura. Resultados indicam que fatores arquitetônicos não possuem tanto poder preditivo quanto as escolhas de hardware em relação ao consumo de energia, água e emissões de carbono. De acordo com o estudo, “fatores arquitetônicos não têm muito poder preditivo como os fatores de hardware” (“Architecture Factors Don’t Hold Much Predictive Power as Hardware Ones”) — Autor do Estudo.

Modelos utilizando o tipo de hardware adequado mostraram maior eficiência, com o uso da unidade de processamento gráfica (GPU) se destacando. Para um único chip NVIDIA A100, o estudo previu que horas extras de treinamento aumentariam o consumo em 0,18%, ilustrando a importância de selecionar cuidadosamente o hardware para um desempenho ideal.

Treinamento e otimização

O tempo de treinamento também revelou um impacto significativo na eficiência energética. “O tempo de treinamento pode ‘desgastar’ a eficiência energética em 0,03% por hora” (“Longer training time can gradually ‘drain’ the overall energy efficiency by 0.03% per hour”) — Autor do Estudo. A média de eficiência energética melhorou levemente ao longo dos anos, em torno de 0,13% por ano, mas a adoção de hardware mais eficiente ainda não é ampla.

O estudo considerou um modelo de regressão gamma com ligação logarítmica para analisar a relação entre a eficiência energética e a data de publicação dos modelos. O uso adequado do tempo e da quantidade de hardware durante o treinamento mostrou ter um efeito crucial sobre o consumo de energia dos modelos.

Resultados e métricas

Com a análise, foi descoberto que o consumo de energia por hora de treinamento em um chip NVIDIA A100 pode chegar a aproximadamente 29,213 kWh, em comparação com o consumo anual médio de uma residência nos EUA, que é de 10,500 kWh. Em um único horário de treinamento, isso representa um aumento significativo no impacto ambiental.

As métricas indicadas pelo estudo são essenciais para guiar futuras pesquisas e desenvolvimentos na eficiência de hardware e estratégias de treinamento. As próximas etapas envolvem a exploração de práticas de treinamento que possam mitigar ainda mais os custos ambientais da IA.

Fonte: (Towards Data Science – AI, ML & Deep Learning)