Pesquisas recentes em machine learning revelam que, apesar da rapidez na busca por informações, ferramentas de AI frequentemente apresentam resultados inconclusivos, levantando questões sobre sua confiabilidade e acurácia.

Contexto da pesquisa

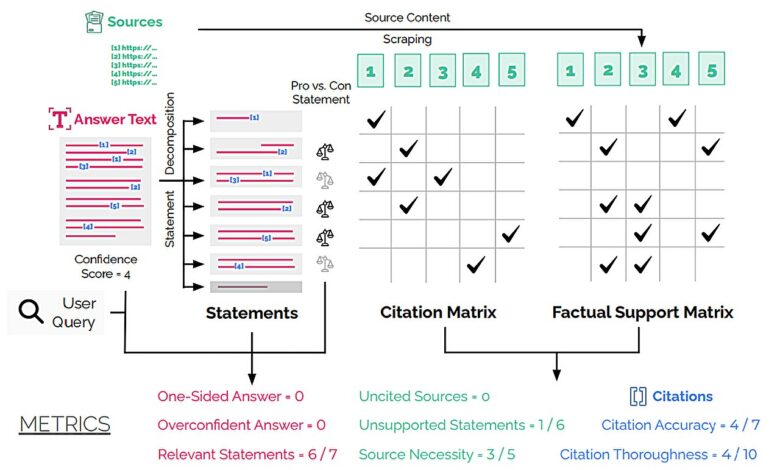

Um estudo realizado por Pranav Narayanan Venkit e sua equipe no Salesforce AI Research investigou a precisão de sistemas de AI como Perplexity, You.com e Bing Chat, evidenciando a necessidade de um framework de auditoria para mensurar a eficácia das informações providas. Os pesquisadores utilizaram uma metodologia chamada DeepTRACE, testando mais de 300 perguntas classificadas em tópicos debatíveis e perguntas de expertise.

Método proposto

O framework DeepTRACE analisou as respostas fornecidas por AI, focando em oito métricas-chave, incluindo precisão nas citações e viés. As perguntas abordaram temas como a viabilidade das energias alternativas em substituir combustíveis fósseis e os principais modelos em hidrologia computacional. Essa abordagem permitiu uma avaliação robusta sobre a contribuição e confiabilidade das ferramentas de AI.

Resultados e impacto

Os resultados foram alarmantes: quase um terço das afirmações feitas por essas ferramentas não possuíam suporte adequado. Para o modelo GPT 4.5 da OpenAI, esse número chega a impressionantes 47%. Os revisores humanos identificaram que, em questões debatíveis, a AI tendia a produzir argumentos unilaterais, criando um fenômeno conhecido como “eco chamber”. Isso ocorre quando os usuários não são expostos a diversas perspectivas, resultando em uma informação potencialmente tendenciosa.

Nossos achados demonstram a eficácia de um framework sociotécnico para auditar sistemas através da interação real com os usuários. Ao mesmo tempo, destacam que sistemas de AI baseados em busca necessitam de avanços substanciais para garantir segurança e eficácia.

— Pranav Narayanan Venkit, Pesquisador, Salesforce AI Research

Embora a pesquisa revele falhas significativas nas ferramentas de AI, ela também fornece um caminho para a avaliação estrutural, permitindo um uso mais consciente da tecnologia. A necessidade de progresso é clara, mas o potencial das aplicações futuras na ciência da informação é promissor.

Fonte: (TechXplore – Machine Learning & AI)