Modelo de IA de código aberto consome seu orçamento computacional

São Paulo — InkDesign News — A mais recente pesquisa sobre modelos de inteligência artificial (IA) de código aberto revela que esses sistemas podem consumir significativamente mais recursos computacionais em comparação com suas alternativas proprietárias. A análise feita pela Nous Research levanta questões sobre a eficiência e os custos associados ao uso de IA em ambientes empresariais.

Tecnologia e abordagem

O estudo focou em 19 modelos de IA, incluindo Large Reasoning Models (LRMs), que empregam cadeias de pensamento para resolver problemas complexos. A pesquisa avaliou a "eficiência de tokens" — a quantidade de unidades computacionais utilizadas em relação à complexidade das soluções propostas. Os modelos de código aberto foram encontrados usando de 1,5 a 4 vezes mais tokens do que os modelos fechados em tarefas idênticas. Em casos de perguntas de conhecimento básico, essa diferença chegou a 10 vezes.

“Modelos de peso aberto usam 1,5 a 4 vezes mais tokens do que os fechados, tornando-os às vezes mais caros por consulta, apesar dos custos menores por token.”

(“Open weight models use 1.5–4× more tokens than closed ones, making them sometimes more expensive per query despite lower per‑token costs.”)— Pesquisadores da Nous Research

Aplicação e desempenho

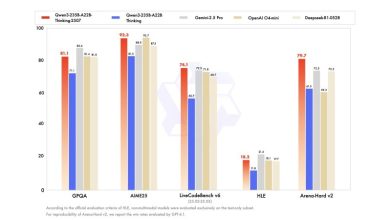

Os modelos que se mostraram mais eficientes foram os da OpenAI, especialmente nas categorias de problemas matemáticos, onde usaram até três vezes menos tokens. O modelo de código aberto da Nvidia, Llama-3.3-nemotron-super-49b-v1, destacou-se como o mais eficiente dentre os modelos de peso aberto analisados. No entanto, modelos mais novos de outras empresas mostraram taxas de uso de tokens excepcionalmente altas, levantando preocupações sobre a viabilidade econômica a longo prazo.

Impacto e mercado

Este panorama desafia a noção comum de que modelos de código aberto são sempre a opção mais econômica. Embora esses modelos geralmente apresentem um custo menor por token, o aumento no número total de tokens necessários para completar tarefas pode anular essa vantagem. A eficiência dos modelos fechados, que têm sido otimizados continuamente para reduzir o uso de tokens, pode fazer os custos das APIs desses sistemas mais competitivos.

A análise sugere que empresas devem considerar não apenas a precisão e o custo por token ao escolher modelos de IA, mas também a eficiência total de computação necessária para tarefas do mundo real.

Os próximos passos podem envolver um foco em otimização da eficiência de token como um critério chave no desenvolvimento de futuros modelos, especialmente em um cenário onde cada token utilizado pode impactar diretamente o orçamento.

Fonte: (VentureBeat – AI)