São Paulo — InkDesign News —

Uma análise aprofundada sobre as normas matemáticas L¹, L² e L∞ evidencia sua importância fundamental em machine learning e deep learning, impactando desde a escolha da função de perda até a regularização e a qualidade das imagens geradas por GANs.

Arquitetura de modelo

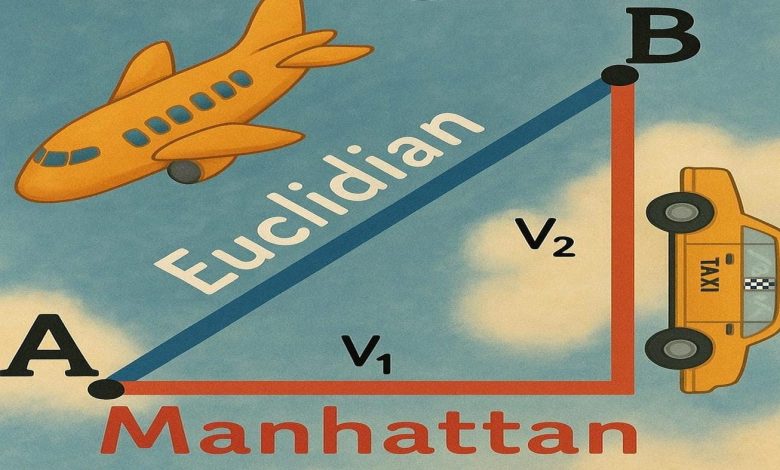

No campo de machine learning, as normas L¹ e L² são aplicadas não apenas como métricas de distância, mas também como funções de perda para medir erro. A norma L¹ enfatiza a robustez contra outliers por tratar todos os erros proporcionalmente, enquanto a norma L² foca na minimização do erro quadrático médio, tornando-se eficaz quando os dados são limpos.

O uso combinado dessas normas em funções objetivo permite encontrar o equilíbrio entre precisão e generalização do modelo, especialmente em técnicas de regularização. Por exemplo, a regularização L¹, conhecida como Lasso, promove a esparsidade eliminando coeficientes menores a zero, implicando em seleção automática de características. Já a L², representada pela regularização Ridge, realiza uma redução suave dos coeficientes, mantendo todos os atributos, útil quando se acredita que todas as entradas são relevantes.

“A otimização e a regularização atuam em direções opostas: otimização tenta ajustar perfeitamente o conjunto de treinamento, enquanto a regularização sacrifica um pouco da precisão para melhorar a generalização.”

(“Optimization and regularization pull in opposite directions: optimization tries to fit the training set perfectly, while regularization deliberately sacrifices a little training accuracy to gain generalization.”)— Marco Hening Tallarico, Pesquisador, Towards Data Science

Treinamento e otimização

No treinamento de redes adversariais generativas (GANs), o equilíbrio entre realismo e fidelidade das imagens é afetado pela escolha da norma. A perda de pixel baseada em L¹ mantém detalhes texturais nítidos, pois considera cada erro de pixel igualmente, enquanto a L², que penaliza grandes erros quadraticamente, tende a produzir imagens mais suaves e borradas.

Essa diferença algébrica mínima explica por que a alteração de L¹ para L² nos GANs pode levar a resultados visuais significativamente distintos, enfatizando a escolha criteriosa da função de perda para preservar alta frequência e contornos nítidos nas imagens geradas.

“A penalidade linear do L¹ mantém detalhes de alta frequência que o L² desfoca.”

(“In vision, the linear penalty of L¹ keeps high-frequency detail that L² blurs away.”)— Marco Hening Tallarico, Pesquisador, Towards Data Science

Resultados e métricas

Expandindo o conceito de distância, a norma Lᵖ generaliza as normas L¹ e L², crescendo para a norma L∞, conhecida como norma máxima. Essa norma é essencial quando se impõe um limite uniforme para todas as coordenadas, garantindo controle no pior caso. A L∞ é aplicada em diversas áreas, desde controle adversarial em deep learning até escalonamento de características e testes de colisão em visão computacional.

Matematicamente, a norma L∞ corresponde ao maior valor absoluto das coordenadas de um vetor, representando um limite superior para deslocamentos e erros individuais, importante para modelos que exigem restrições rígidas e segurança.

“A norma máxima aparece sempre que se necessita de uma garantia uniforme ou controle no pior caso.”

(“The max-norm shows up any time you need a uniform guarantee or worst-case control.”)— Marco Hening Tallarico, Pesquisador, Towards Data Science

Esses diferentes tipos de normas, suas propriedades algébricas e impactos práticos no machine learning demonstram a importância crítica da escolha correta da medida de distância ou penalidade. O desenvolvimento e otimização de modelos de deep learning podem se beneficiar significativamente desses insights para ampliar a eficiência e a robustez dos sistemas.

Próximos passos na pesquisa incluem a exploração das normas Lᵖ para valores fracionários ou não inteiros de p, seus efeitos teóricos e aplicações práticas, ampliando ainda mais o conjunto de ferramentas para modelagem e análise em inteligência artificial.

Fonte: (Towards Data Science – AI, ML & Deep Learning)