São Paulo — InkDesign News —

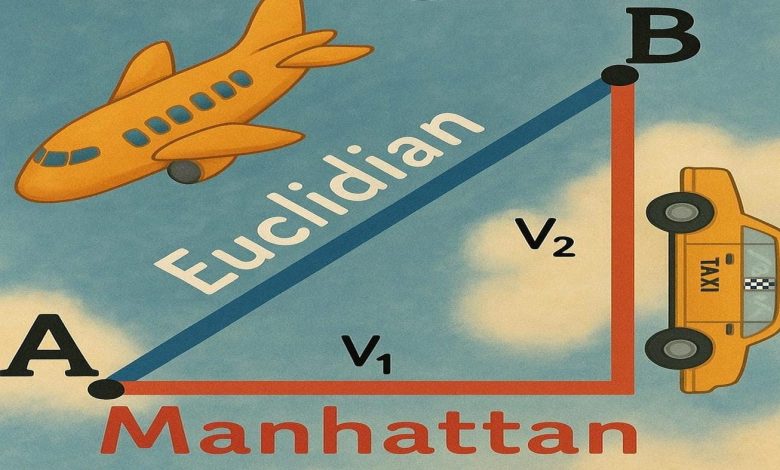

Normas de distância no machine learning e deep learning desempenham papéis decisivos na modelagem, regularização e geração de dados. Entender as diferenças entre as normas L¹ e L², bem como a generalização para a norma L∞, auxilia no desenvolvimento de modelos mais robustos e interpretáveis.

Arquitetura de modelo

As normas L¹ e L² são fundamentais para medir erros e regularizar modelos. A norma L¹, associada à soma dos valores absolutos, promove sparsidade ao zerar pesos, efetivando seleção de atributos no modelo (como no Lasso). Já a norma L² regulariza suavemente, encolhendo coeficientes sem anular, útil para manter todos os recursos em modelos como o Ridge.

“Adição da penalização L¹ 𝛼∥w∥₁ promove sparsidade — muitos coeficientes se tornam zero.”

(“Adding an L¹ penalty 𝛼∥w∥₁ promotes sparsity — many coefficients collapse all the way to zero.”)— Marco Hening Tallarico, Pesquisador em AI

Essa diferença na estrutura das penalizações modela a arquitetura para objetivos distintos: modelos robustos com menos variáveis ou modelos estáveis e com todos os inputs considerados.

Treinamento e otimização

A função de perda com norma L² é suave e diferenciável em todos os pontos, facilitando a otimização com métodos de gradiente. Em contrapartida, L¹ apresenta uma derivada com descontinuidades que favorece a anulação de pesos, mas complica otimização direta. No entanto, a combinação dos dois permite ajustar o balanço entre viés e variância, melhorando a generalização.

No domínio das redes generativas adversariais (GANs), a substituição da perda pixel a pixel de L¹ por L² resulta em imagens mais borradas, devido ao efeito de médias suavizadas das texturas e detalhes. A perda L¹, por penalizar linearmente o erro em cada pixel, favorece imagens nítidas.

“Trocar a perda de pixel para L² faz com que o gerador produza imagens mais suaves e borradas por prever a média das texturas plausíveis.”

(“Swap the pixel loss to L² and you square pixel errors; large residuals dominate the objective, so G plays it safe by predicting the mean of all plausible textures — result: smoother, blurrier outputs.”)— Marco Hening Tallarico, Especialista em GANs

Resultados e métricas

Experimentos com regressão ilustram claramente o efeito das duas regularizações: com Lasso (L¹), muitos coeficientes desaparecem completamente, reduzindo a dimensionalidade, enquanto com Ridge (L²) os coeficientes são diminuídos, mas permanecem ativos. O aumento do parâmetro α intensifica os efeitos, podendo eliminar variáveis importantes no Lasso.

A norma L∞ generaliza a noção de distância, medindo essencialmente o maior valor absoluto entre coordenadas, o que permite controle rigoroso e garantias de pior caso — essencial em cenários onde se exige limites máximos por dimensão, como proteção adversarial e escalonamento de features.

“A norma L∞ aparece sempre que se precisa de uma garantia uniforme ou controle do pior caso.”

(“The max-norm shows up any time you need a uniform guarantee or worst-case control.”)— Marco Hening Tallarico, Pesquisador em AI

Aplicações práticas do L∞ incluem limite de erro máximo, escalonamento Max-Abs, restrição de pesos para evitar violações excessivas em fairness, e avaliação rápida em algoritmos baseados em distâncias como k-NN.

Essas análises reforçam a importância da escolha criteriosa da norma segundo o contexto da tarefa de machine learning, oferecendo ferramentas para equilibrar precisão, robustez e interpretabilidade nos modelos.

Fonte: (Towards Data Science – AI, ML & Deep Learning)