São Paulo — InkDesign News —

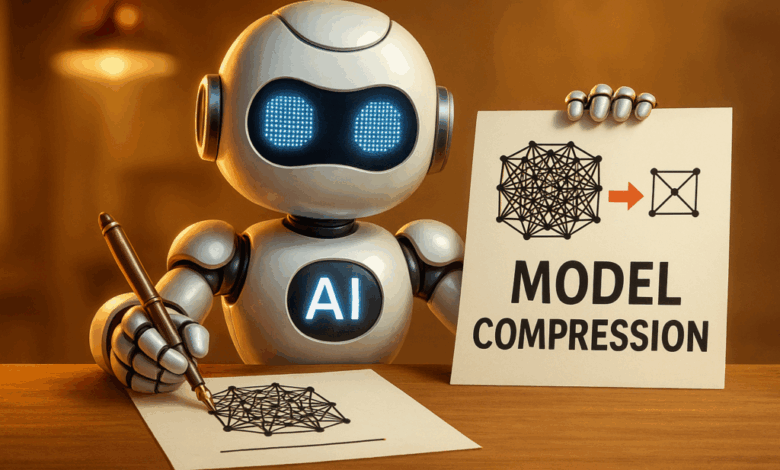

Em machine learning, a compressão de modelos tornou-se essencial para viabilizar modelos grandes e complexos em dispositivos com recursos limitados. Quatro técnicas fundamentais garantem eficiência sem perda significativa de desempenho.

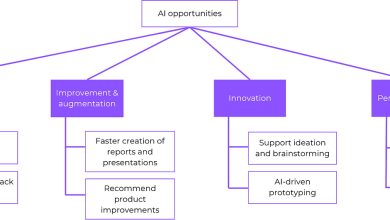

Arquitetura de modelo

A compressão de modelos em deep learning explora redundâncias e limita as demandas computacionais. Uma das estratégias mais intuitivas é o pruning, que remove pesos considerados menos importantes, geralmente configurando-os para zero, reduzindo assim a complexidade do modelo. O pruning pode ser estruturado, removendo componentes inteiros como canais em camadas convolucionais, ou não estruturado, eliminando pesos individuais independentemente de sua posição.

“Poda é uma forma de revelar esta sub-rede.”

(“Pruning is one way to unveil this sub-network.”)— Maxime, Autor do artigo

Já o low-rank factorization utiliza decomposição matricial para representar matrizes de pesos por meio da multiplicação de duas matrizes menores, reduzindo o número total de parâmetros sem comprometer a funcionalidade. Exemplos modernos, como o LoRA (Low-Rank Adaptation), aplicam essas atualizações de baixa rank durante fine-tuning para otimizar grandes modelos de linguagem.

Treinamento e otimização

Além de reduzir a quantidade de parâmetros, o quantization reduz a precisão dos números que representam os pesos, convertendo valores de 32 bits para 8 ou até 4 bits, economizando memória e acelerando inferência. Essa técnica pode ser usada pós-treinamento (PTQ) com métodos estáticos ou dinâmicos, ou integrada no treinamento com awareness de quantização (QAT) para robustez contra erros de arredondamento.

“Quantização é muito flexível!”

(“Quantization is very flexible!”)— Maxime, Autor do artigo

Por fim, a knowledge distillation foca em transferir o conhecimento de um modelo grande e complexo (professor) para um modelo menor (aluno), treinando o modelo menor para replicar o comportamento do maior. Essa técnica combina a perda tradicional de classificação com uma perda de distilação baseada em divergência KL entre as distribuições de probabilidades, gerando modelos compactos de alta performance.

Resultados e métricas

Segundo a hipótese do bilhete premiado (“Lottery Ticket Hypothesis”), redes neurais possuem sub-redes menores capazes de alcançar desempenho comparável ao modelo original, mostrando que a compressão pode manter a acurácia. Tecnologias combinando técnicas como quantização e low-rank factorization, por exemplo no modelo DeepSeek-R1-Distill-Llama-8B quantizado, demonstram avanços significativos em eficiência sem perda substancial do desempenho.

“Esta rede pode realizar tão bem quanto a original.”

(“This network can do as well as the original one.”)— Frankle & Carbin, Pesquisadores

Combinando essas técnicas, é possível reduzir drasticamente os custos de armazenamento e cálculo, acelerando a inferência e adequando modelos para ambientes de produção com restrições rigorosas.

Em suma, entender e aplicar essas metodologias de compressão é fundamental para a evolução da inteligência artificial prática. O futuro aponta para projetos que integram múltiplas técnicas para otimizar ainda mais modelos de deep learning, facilitando sua implementação em dispositivos edge e democratizando seu acesso.

Confira mais conteúdos sobre machine learning e deep learning em nossos arquivos na categoria de machine learning e categoria de deep learning.

Fonte: (Towards Data Science – AI, ML & Deep Learning)