São Paulo — InkDesign News —

A pesquisa recente sobre machine learning revela abordagens inovadoras para otimizar o treinamento de LLMs (Modelos de Linguagem de Aprendizado). Um novo método desenvolvido pelo Tongyi Lab da Alibaba Group promete redução significativa nos custos associados à formação desses modelos complexos.

Contexto da pesquisa

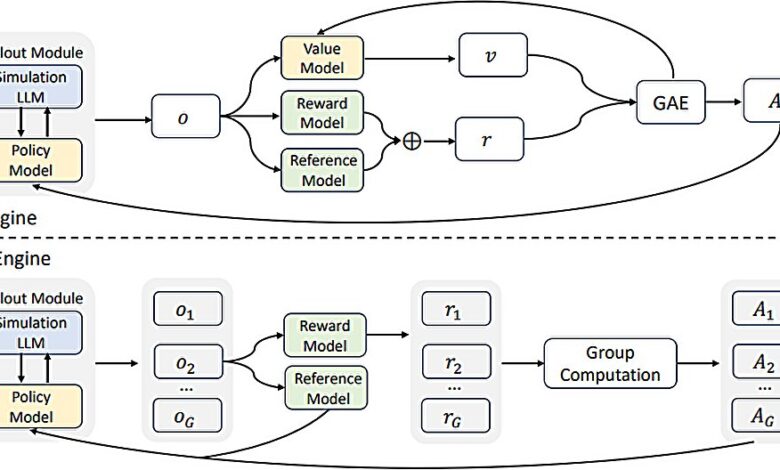

Com a crescente popularidade de LLMs, como o ChatGPT, os custos para sua operação dispararam, levando empresas a buscar alternativas mais viáveis. O trabalho da equipe na Alibaba foca em recursos limitados e eficiência em treinamento, apresentando a proposta do ZeroSearch.

Método proposto

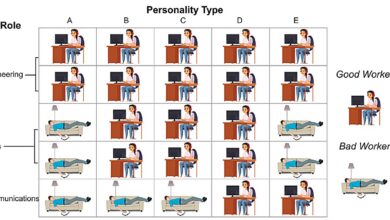

O ZeroSearch se diferencia por eliminar a necessidade de chamadas de API a mecanismos de busca. Em vez disso, utiliza documentos simulados gerados por IA para imitar as saídas de motores de busca tradicionais, como o Google. A equipe sugere que esta abordagem não apenas reduz os requisitos de recursos, mas também melhora a qualidade do treinamento, já que os dados gerados não têm a natureza imprevisível dos resultados de busca públicos.

“A nova técnica permite degradar lentamente a qualidade dos documentos produzidos, criando cenários desafiadores para recuperação.”

(“The new technique allows for slowly degrading the quality of documents produced as a way to challenge retrieval scenarios.”)— Hao Sun, Pesquisador, Alibaba Group

Resultados e impacto

Em testes, o custo de treinamento usando o ZeroSearch foi de $70,80 para 64.000 consultas, comparado a $586,70 com APIs do Google. Resultados de modelos baseados em ZeroSearch foram, em geral, iguais ou superiores aos obtidos por métodos tradicionais. Contudo, os pesquisadores alertam para um trade-off: o método ZeroSearch pode requerer até quatro GPUs A100, enquanto o método com Google API não tem essa exigência de hardware.

“Embora o treinamento com ZeroSearch seja mais econômico, isso pode apresentar um desafio em termos de sustentabilidade.”

(“While ZeroSearch training is more cost-effective, this could present a trade-off in terms of sustainability.”)— Hao Sun, Pesquisador, Alibaba Group

As implicações futuras desse método são promissoras, abrindo caminho para aplicações mais acessíveis e de maior qualidade em IA. A equipe do Tongyi Lab sugere que essa abordagem pode ter um impacto significativo em diversas áreas de pesquisa em machine learning e inteligência artificial.

Fonte: (TechXplore – Machine Learning & AI)