São Paulo — InkDesign News —

A pesquisa sobre machine learning e inteligência artificial tem avançado, especialmente na detecção de comportamentos indesejados em plataformas online. Um estudo recente realizado na Universidade de Tsukuba destaca a eficácia de modelos de linguagem para prever desvio em conversas online.

Contexto da pesquisa

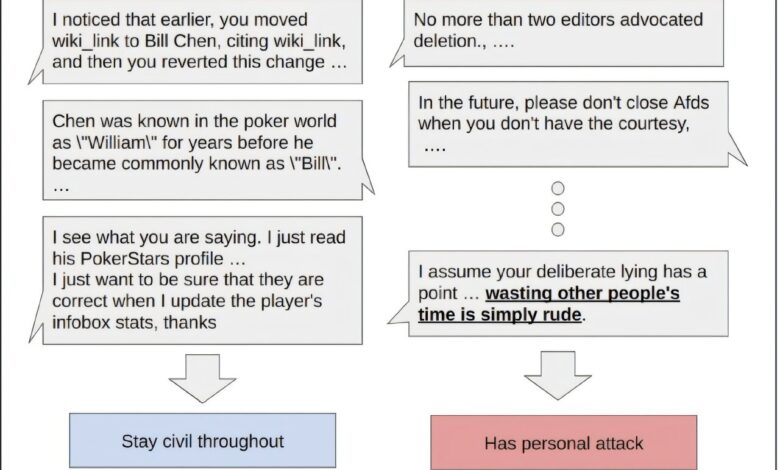

Em ambientes virtuais como salas de chat e redes sociais, os conflitos pessoais frequentemente desestabilizam discussões. Modelos preditivos tradicionais, por sua vez, baseiam-se em dados específicos de cada plataforma, o que eleva os custos e limita sua aplicabilidade.

Método proposto

Os pesquisadores aplicaram um método de predição “zero-shot” utilizando modelos de linguagem de grande escala (LLMs) para detectar desvios nas conversações. Esse enfoque diferenciado permitiu a comparação entre LLMs não treinados e um modelo de aprendizado profundo treinado em conjuntos de dados curados.

Resultados e impacto

Os resultados revelaram que os LLMs não treinados apresentaram precisão comparável, e em alguns casos superior, ao modelo de aprendizado profundo. O estudo conclui que os operadores de plataformas podem implementar ferramentas de moderação eficazes e de baixo custo, promovendo comunidades online mais saudáveis.

“As descobertas sugerem que é possível investir em modelos gerais para mediação sem grandes gastos”

(“The findings suggest that it is possible to invest in general-purpose models for mediation without substantial expenditures”)— Kenya Nonaka, Pesquisador, Universidade de Tsukuba

Esses resultados podem ter ampla aplicação, incentivando o desenvolvimento de soluções que melhorem a interação nas redes sociais e colaborem para um ambiente digital mais harmonioso.

Fonte: (TechXplore – Machine Learning & AI)