São Paulo — InkDesign News —

A pesquisa em machine learning tem avançado significativamente, particularmente na área de inteligência artificial (AI). Um novo estudo busca proporcionar um controle mais preciso sobre modelos de linguagem, prometendo resultados mais confiáveis e adaptáveis.

Contexto da pesquisa

A pesquisa foi realizada na Universidade da Califórnia, San Diego (UCSD) pelo professor Mikhail Belkin, do Halıcıoğlu Data Science Institute. O grupo se concentrou em melhorar as interações com grandes modelos de linguagem (LLMs), como o Google Gemini e o OpenAI ChatGPT.

Método proposto

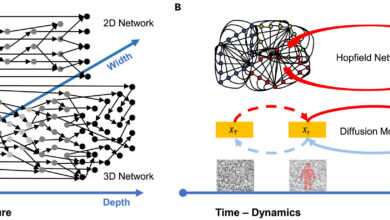

Os pesquisadores desenvolveram um método inovador de “aprendizado de características não lineares”, que permite identificar e manipular características subjacentes importantes dentro das complexas redes dos LLMs. Esse processo envolve a análise das ativações internas do modelo em diferentes camadas, visando ajustar características responsivas a conceitos específicos, como toxicidade ou precisão factual.

“Parece que estamos ganhando uma compreensão mais profunda do processo de pensamento do aplicativo de IA. Isso nos permite não apenas prever que tipo de saídas o modelo vai gerar, mas também influenciá-lo ativamente em direção a respostas mais úteis e menos prejudiciais.”

(“It’s like we’re gaining a deeper understanding of the AI app’s internal thought process. This allows us to not only predict what kind of outputs the model will generate, but also to actively influence it towards more helpful and less harmful responses.”)— Mikhail Belkin, Professor, UC San Diego

Resultados e impacto

O modelo foi testado em diversas tarefas, incluindo a detecção e mitigação de alucinações e comportamentos prejudiciais. Os pesquisadores mostraram que suas técnicas podem direcionar LLMs a compreender melhor conceitos em diferentes idiomas, desde o inglês shakespeariano até a linguagem poética. Além disso, a pesquisa sugere que a nova abordagem pode tornar os LLMs mais eficientes, permitindo ajustes com menos dados e recursos computacionais.

“Um dos benefícios significativos deste novo método é seu potencial para tornar os LLMs mais eficientes e econômicos. Portanto, acreditamos que podemos ajustar esses modelos poderosos usando menos dados.”

(“One of the significant benefits of this new method is its potential to make LLMs more efficient and cost-effective. By focusing on the crucial internal features, we believe that we can fine-tune these powerful models using less data and computational resources.”)— Mikhail Belkin, Professor, UC San Diego

As implicações deste estudo são vastas, podendo levar à criação de aplicações de IA mais personalizadas, como assistentes virtuais precisos em informações médicas ou ferramentas de escrita criativa que evitem clichês e estereótipos prejudiciais. A equipe disponibilizou seu código publicamente, promovendo investigações futuras em segurança e controle da IA.

Fonte: (TechXplore – Machine Learning & AI)