LLM ganha controles parentais após tragédia, mas especialistas alertam

São Paulo — InkDesign News —

A inteligência artificial (AI) e o aprendizado de máquina (machine learning) estão evoluindo rapidamente, levantando questões sobre como essas tecnologias interagem com questões sensíveis, como saúde mental. A recente introdução de controles parentais para chatbots, como o ChatGPT, oferece uma nova perspectiva sobre a responsabilidade na utilização desses sistemas em ambientes delicados.

Contexto da pesquisa

A OpenAI anunciou a implementação de controles parentais para o ChatGPT, alegando que isso permitirá aos pais monitorar interações que podem indicar “angústia emocional” de seus filhos. Isso segue a apresentação de um processo judicial contra a empresa, alegando que suas tecnologias contribuíram para o suicídio de um adolescente.

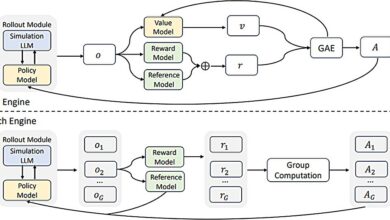

Método proposto

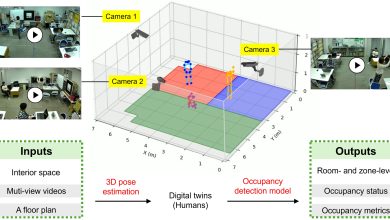

O modelo de AI em questão utiliza um sistema de alertas que notifica os pais caso o chatbot detecte certas palavras-chave relacionadas ao estresse emocional. Contudo, especialistas questionam a eficácia e a precisão dessa abordagem dada a natureza das tecnologias de aprendizado profundo (deep learning), que incluem Transformers e Modelos de Linguagem de Grande Escala (LLMs).

“A pesquisa mostrou repetidamente que a maioria dos LLMs não é boa em emoções e não detém o risco além de palavras-chave limitadas.”

(“Research has shown over and over again that most LLMs are not good at emotions and they’re not good at detecting risk beyond limited keywords.”)— Annika Marie Schoene, Cientista de Pesquisa, Northeastern University

Resultados e impacto

As métricas de desempenho dessa abordagem ainda não foram amplamente divulgadas, mas a tecnologia enfrenta desafios significativos em proporcionar alertas confiáveis para os pais. O sistema de alerta proposto pode falhar em captar a complexidade das interações emocionais, um aspecto crucial em qualquer tecnologia que aborda saúde mental.

“Se a primeira etapa de segurança é transferir a responsabilidade para o usuário, isso não é um bom primeiro passo.”

(“If that first step is directly tied to shifting the responsibility to the user, I can’t say that that’s a good first step.”)— Cansu Canca, Diretora da Prática de AI Responsável, Northeastern University

As aplicações potenciais dessa tecnologia abrangem desde o suporte na educação até a criação de ambientes virtuais mais seguros para interações. Avanços futuros podem incluir métodos que permitam que os usuários se declarem como vulneráveis a certos tópicos, utilizando tecnologia semelhante a abordagens de controle de armas em legislações de segurança.

Fonte: (TechXplore – Machine Learning & AI)