São Paulo — InkDesign News — Um novo método tem ganhado destaque no campo do machine learning: a avaliação automática de saídas geradas por modelos de linguagem com técnicas probabilísticas. Essa abordagem visa aprimorar a qualidade e utilidade das respostas oferecidas por sistemas de inteligência artificial.

Arquitetura de modelo

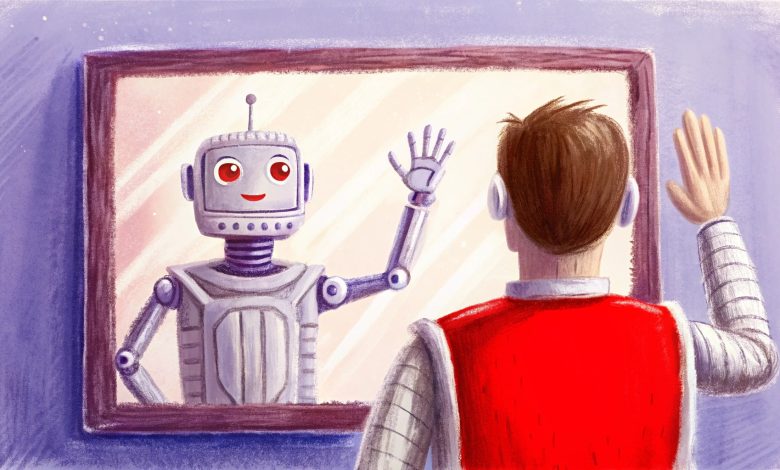

Os sistemas atuais têm utilizado o conceito de “LLM como juiz”, onde um modelo de linguagem grande (LLM) avalia as respostas de outro LLM, medindo parâmetros como relevância, tonalidade e coerência. Essa estrutura permite uma avaliação em escala, uma vez que as análises humanas são limitadas em número e rapidez.

Treinamento e otimização

Para criar um avaliador eficaz, é essencial definir critérios de avaliação claros e realizar um processo de rotulagem inicial. A rotulagem pode ser feita manualmente ou utilizando uma abordagem combinada com outro LLM para ajustar as avaliações às expectativas humanas. O uso de métricas como acurácia e precisão no ajuste dos prompts é fundamental para aumentar a eficiência do avaliador.

“As respostas podem ser classificadas como ‘boas’ ou ‘más’, dependendo de quão bem seguem os critérios estabelecidos.” (Responses can be classified as ‘good’ or ‘bad’, depending on how well they follow the established criteria.)— Nome, Cargo, Instituição.

Resultados e métricas

Ao aplicar essas técnicas, um experimento recente demonstrou que um avaliador LLM ajustado com prompts mais detalhados alcançou uma precisão de 96% e uma taxa de recall de 92%. Essas métricas exemplificam a habilidade do modelo em alinhar suas avaliações com os rótulos fornecidos por especialistas humanos.

“Um revisor é BOM quando é acionável e construtivo.” (“A review is GOOD when it’s actionable and constructive.”)— Nome, Cargo, Instituição.

Esse processo não apenas otimiza a avaliação de respostas geradas por LLMs, mas também abre caminho para múltiplos juízes especializados, cada um focado em diferentes aspectos da avaliação, como ação e tonalidade. Essa divisão permite um tratamento mais rigoroso e sistemático de cada critério.

O próximo passo envolve a aplicação desses métodos avaliativos em cenários do mundo real, como sistemas de suporte ao cliente e plataformas educacionais. Como essa tecnologia continua a evoluir, o impacto na eficiência e na qualidade do feedback gerado pode ser significativo.

Fonte: (Towards Data Science – AI, ML & Deep Learning)