São Paulo — InkDesign News — Pesquisas recentes na Sony AI apresentam avanços significativos em robótica cognitiva e automação visual, com foco em geração de imagens e otimização de modelos de difusão para aplicações em tempo real, utilizando algoritmos avançados de visão computacional e machine learning.

Tecnologia aplicada

O trabalho liderado por Yuki Mitsufuji aborda dois desafios na geração automatizada de imagens: a síntese de novas vistas a partir de uma única imagem (single-shot novel view synthesis) e a redução do custo computacional de modelos de difusão para geração rápida. No primeiro caso, o método GenWarp utiliza um modelo de difusão com injeção de informações semânticas e profundidade monocular via mecanismo de cross-attention, eliminando a tradicional abordagem em duas fases (warp e interpolação). Isso melhora a qualidade e precisão das imagens geradas mesmo para mudanças severas de ângulo, demonstrado por métricas como FID e PSNR.

No segundo desafio, o modelo PaGoDA propõe uma arquitetura de treinamento progressivo para um gerador one-step derivado de um professor (teacher) de baixa resolução. A técnica elimina a necessidade de re-treinamento para diferentes resoluções, otimizando o processo de distilação e tornando a geração até 80 vezes mais rápida ao reduzir drasticamente a quantidade de passos iterativos, comum nos modelos de difusão tradicionais.

Desenvolvimento e testes

Ambos os modelos foram testados em ambientes controlados de laboratório com imagens 2D, utilizando conjuntos de dados para análise objetiva da qualidade e velocidade de geração. GenWarp foi avaliado subjetivamente por meio de um demo aberto, onde usuários podem visualizar imagens originais e suas versões geradas em múltiplos ângulos (https://huggingface.co/spaces/Sony/genwarp). PaGoDA, por sua vez, foi validado em diversas resoluções (64×64 a 256×256 e superiores) para assegurar a robustez e eficiência do treinamento progressivo.

Impacto e aplicações

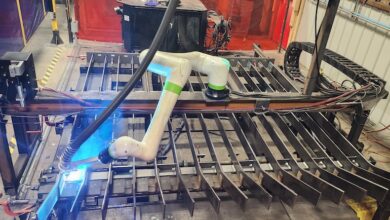

Estes avanços têm implicações práticas importantes para robótica e automação, especialmente em sistemas que demandam geração rápida de imagens para navegação, inspeção visual e animações em tempo real. A possibilidade de geração one-step pode ser expandida para outras modalidades, incluindo som, conforme indicam os pesquisadores. Tal melhoria promete reduzir latências e aumentar a autonomia de robôs em ambientes dinâmicos, possibilitando respostas mais rápidas e precisas.

“Queremos alcançar a geração em tempo real, não apenas para imagens, mas também para som.”

(“Ultimately, we want to achieve real-time generation, and not just have this generation be limited to images. Real-time sound generation is an area that we are looking at.”)— Yuki Mitsufuji, Lead Research Scientist, Sony AI

Além disso, a integração entre modelos de difusão de alta qualidade e eficiência computacional posiciona-se como uma ferramenta estratégica para automação de processos criativos e industriais que utilizam visão computacional e aprendizado profundo.

Saiba mais em Robótica e Automação.

Fonte: (Robohub – Robótica & Automação)