São Paulo — InkDesign News — A Huawei, por meio do seu Laboratório de Sistemas de Computação em Zurique, lançou um novo método de quantização open-source focado em modelos de linguagem de grande porte (LLMs). Essa técnica, chamada SINQ (Quantização Normalizada por Sinkhorn), tem como objetivo reduzir as demandas de memória sem comprometer a qualidade da saída.

Tecnologia e abordagem

O SINQ é projetado para ser rápido e não requer calibração, permitindo fácil integração em workflows de modelos existentes. A metodologia se destaca por duas inovações principais: a Escala de Duplo Eixo, que utiliza vetores de escala separados para linhas e colunas, e a Normalização no Estilo Sinkhorn-Knopp, que minimiza um novo proxy chamado “desbalanceamento matricial”. Esse método se mostrou mais eficaz do que alternativas como kurtosis na melhoria do desempenho da quantização.

Em termos de execução, SINQ permite que modelos que antes requeriam mais de 60 GB de memória operem em configurações de aproximadamente 20 GB, sendo aplicável em GPUs de alto desempenho como a Nvidia GeForce RTX 4090, que é significativamente mais acessível do que opções empresariais como a A100.

Aplicação e desempenho

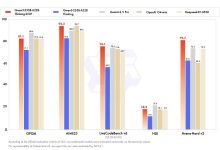

Testes conduzidos com uma variedade de arquiteturas e modelos, como as séries Qwen3, LLaMA e DeepSeek, mostraram resultados promissores. No WikiText2 e C4, o SINQ frequentemente apresentou uma redução na perplexidade e nas taxas de erro, equiparando-se ao desempenho de soluções calibradas. O tempo de quantização do SINQ é cerca de duas vezes mais rápido em comparação com o HQQ e mais de 30 vezes mais eficiente que o AWQ, sendo ideal para ambientes de pesquisa e produção onde o tempo de quantização é crucial.

“O SINQ é uma solução plug-and-play que mantém um forte desempenho em configurações de baixa precisão, sem exigir dados de calibração ou dependências entre camadas.”

(“SINQ is a plug-and-play solution that maintains strong performance in low-precision settings without requiring calibration data or inter-layer dependencies.”)— Huawei Research Team, Huawei

Impacto e mercado

O impacto econômico da quantização não deve ser subestimado. Enquanto instâncias baseadas em A100 custam entre US$ 3 e US$ 4,50 por hora, GPUs como a RTX 4090 estão disponíveis por US$ 1 a US$ 1,50 por hora em diversas plataformas. Essa diferença pode resultar em economias de milhares de dólares ao longo do tempo, especialmente para cargas de trabalho de inferência prolongadas.

A adoção do SINQ pode democratizar o uso de LLMs, permitindo que desenvolvedores e pesquisadores implementem modelos grandes sem uma diminuição significativa na qualidade ou compatibilidade. A Huawei planeja integrar o SINQ com o Hugging Face Transformers e disponibilizar modelos pré-quantizados em breve, evidenciando um movimento estratégico em direção a uma maior acessibilidade e eficiência na AI.

Fonte: (VentureBeat – AI)