Google Gemini ajusta modelo de inteligência artificial com controle de raciocínio

São Paulo — InkDesign News — A inteligência artificial avança com modelos que dedicam mais tempo ao raciocínio para resolver problemas complexos. Contudo, o aumento no custo computacional e o risco de “overthinking” desafiam a adoção prática dessas soluções, segundo especialistas da DeepMind, Google e Hugging Face.

Contexto da pesquisa

Pesquisadores da DeepMind, laboratório de inteligência artificial ligado ao Google, têm impulsionado o desenvolvimento de modelos de machine learning projetados para “pensar” com mais profundidade, dedicando tempo extra a processos lógicos para aprimorar respostas em tarefas desafiadoras. Entre os exemplos está o modelo DeepSeek R1, lançado no início de 2025, que ganhou destaque por sua capacidade de resolver problemas complexos ao iterar hipóteses durante o raciocínio. O objetivo desses modelos é melhorar a performance prática evitando a criação de novos algoritmos do zero. Conforme Jack Rae, principal cientista pesquisador da DeepMind, “We’ve been really pushing on ‘thinking’” (“Temos realmente investido em ‘pensar’”).

A motivação para esses avanços reside na busca de soluções mais eficazes para a análise de códigos, síntese de informações de múltiplos documentos e outras tarefas cognitivas que exigem mais do que respostas superficiais. No entanto, o custo energético e financeiro cresce conforme o tempo de processamento aumenta, o que levanta questões sobre sustentabilidade ambiental e viabilidade econômica, como destaca um artigo do MIT Technology Review.

Método e resultados

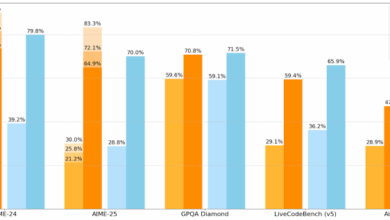

Os modelos de raciocínio empregam algoritmos baseados em arquiteturas Transformer, semelhantes ao GPT-4, mas com mecanismos que permitem múltiplas iterações internas para refinar um resultado. Essas iterações, realizadas sobre grandes conjuntos de dados, demandam maior energia computacional, ocasionando custos que podem ultrapassar 200 dólares por tarefa em certos benchmarks da área, de acordo com placares online de desempenho (“Leaderboards”).

Koray Kavukcuoglu, diretor técnico da DeepMind, destaca o princípio por trás desse método: “The more you can iterate over certain hypotheses and thoughts, it’s going to find the right thing” (“Quanto mais você pode iterar sobre certas hipóteses e pensamentos, mais ele encontrará a resposta correta”).

Nem sempre, porém, essa abordagem é eficiente. Tulsee Doshi, líder de produto da Gemini, afirma que “for simple prompts, the model does think more than it needs to” (“para comandos simples, o modelo pensa mais do que precisa”). Isso gera gastos desnecessários e aumenta a pegada ambiental da inteligência artificial. Nathan Habib, engenheiro da Hugging Face, observa que esse “overthinking” é comum no mercado, onde muitos fornecedores aplicam modelos de raciocínio mesmo quando não há real necessidade, visando mostrar avanços em IA.

Um exemplo citado envolve um modelo de raciocínio avançado tentando resolver uma questão de química orgânica. Após um início promissor, o sistema começou a apresentar repetições e incertezas constantes, prolongando tarefas além do esperado. Kate Olszewska, avaliadora dos modelos Gemini na DeepMind, também reporta casos em que certos modelos ficam presos em loops de pensamento.

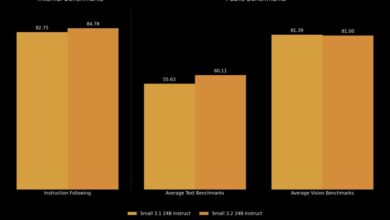

Em resposta a esses desafios, Google DeepMind lançou uma funcionalidade inédita no modelo Gemini Flash 2.5: um controle deslizante que permite aos desenvolvedores regularem o nível de raciocínio aplicado a uma tarefa computacional. Essa ferramenta tem como objetivo ajustar o uso da capacidade computacional conforme a complexidade da demanda, otimizando custos. O uso do raciocínio ativo aumenta o custo das respostas em cerca de seis vezes.

Implicações e próximos passos

Os modelos com maior capacidade de raciocínio prometem avanços significativos ao enfrentarem problemas que requerem maior reflexão e análise detalhada, como depuração de código e síntese de dados complexos. No entanto, o custo financeiro e ambiental associados aos cálculos intensivos cria uma tensão entre precisão e eficiência.

Além disso, a experiência mostra que a aplicação indiscriminada de modelos de raciocínio pode reduzir o aproveitamento prático da IA, desviando recursos para problemas que poderiam ser resolvidos com abordagens mais simples e econômicas. Habib sintetiza o dilema: a melhora de performance é “undeniable” (“incontestável”) para casos específicos, mas nem sempre para a maioria das aplicações cotidianas.

A introdução do “dial” de raciocínio da Gemini representa uma tentativa de balancear desempenho e custo, abrindo caminho para uma utilização mais criteriosa destes modelos. O próximo passo para pesquisadores e desenvolvedores será aprimorar mecanismos de controle automatizado que ajustem o nível de raciocínio conforme a demanda, minimizando ciclos improdutivos e o impacto ambiental.

Assim, o desenvolvimento de modelos de IA capazes de raciocinar profundamente deve avançar em paralelo à preocupação com eficiência energética e ética computacional, guiando o futuro da inteligência artificial para aplicações mais sustentáveis e práticas na indústria e pesquisa.

Fonte: (MIT Technology Review – Artificial Intelligence)