São Paulo — InkDesign News — A ascensão de modelos de linguagem local representa uma nova era no campo da inteligência artificial, onde estados, organizações e indivíduos buscam maior autonomia e controle sobre suas experiências em machine learning.

Contexto da pesquisa

Muitos usuários estão cada vez mais cientes da concentração do poder de inteligência artificial nas mãos de poucas empresas. Por essa razão, a adoção de modelos locais tem atraído interesse crescente. Pistilli afirma que “a tecnologia significa poder” e que “quem possui a tecnologia também possui o poder”. Iniciativas como essa refletem o desejo de descentralização e controle sobre os dispositivos que utilizamos em nossas interações digitais.

Método e resultados

A instalação e uso de LLMs (Modelos de Linguagem de Grande Escala) locais não requer expertise avançada em programação. Ferramentas como o Ollama permitem que usuários com conhecimento básico de linha de comando baixem e rodem diversos modelos com um único comando. Alternativamente, o LM Studio oferece uma interface amigável que facilita a interação com modelos provenientes da Hugging Face, categorizando-os em funcionalidade e requisitos de hardware.

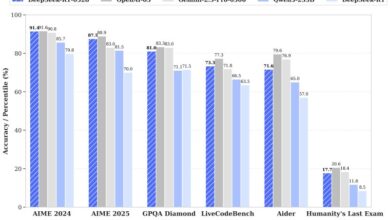

Os modelos locais, embora menos poderosos que suas contrapartes comerciais, apresentam vantagens em termos de consistência e controle. Willison observa que “executar modelos locais é um bom exercício para desenvolver uma intuição mais ampla sobre o que essas ferramentas podem fazer”.

Implicações e próximos passos

A adoção de LLMs locais permite uma variedade de aplicações, desde educação até pesquisas especializadas, sem as limitações e mudanças frequentes impostas pelos fornecedores online. Contudo, a utilização de modelos menores pode apresentar desafios como a proclividade a “alucinações” – erros nos dados produzidos – que, embora limitados, podem ensinar usuários a perceber as armadilhas de modelos maiores.

Os pequenos modelos podem, por exemplo, alucinar mais frequentemente e de forma mais evidente do que Claude, GPT e Gemini, e ver essas alucinações pode ajudar a desenvolver a percepção de como e quando os modelos maiores também podem enganar.

(“Small models may, for example, hallucinate more frequently and more obviously than Claude, GPT, and Gemini, and seeing those hallucinations can help you build up an awareness of how and when the larger models might also lie.”)— Willison, Pesquisador

Embora a capacidade computacional necessária seja um fator limitante, com cada bilhão de parâmetros exigindo cerca de 1 GB de RAM, a experimentação com diferentes modelos oferece uma oportunidade valiosa para aprendizado e desenvolvimento de habilidades críticas em tecnologia.

Por fim, a exploração dos LLMs locais pode não apenas democratizar o acesso à inteligência artificial, mas também preparar os usuários para um futuro digital mais consciente e autônomo.

Fonte: (MIT Technology Review – Artificial Intelligence)