São Paulo — InkDesign News — A quantização pós-treinamento está se destacando como uma técnica essencial em machine learning, especialmente para modelos de linguagem de grande escala (LLMs). Este artigo analisa o método EoRA, que visa corrigir erros de quantização.

Arquitetura de modelo

A quantização é um processo que converte os parâmetros do modelo de formatos de alta precisão, como ponto flutuante de 32 bits (FP32), para formatos de menor precisão, geralmente inteiro de 8 bits (INT8) ou até 4 bits (INT4). Para ilustrar, um modelo como o Llama 3 com 70 bilhões de parâmetros ocupa cerca de 140 GB em FP16, mas pode ser reduzido para aproximadamente 40 GB com quantização de 4 bits. Apesar de uma redução significativa, esses modelos ainda superam a capacidade de memória da maioria das GPUs de consumo, que variam de 24 GB a 32 GB de VRAM, o que torna a quantização a 2 bits um objetivo desejável.

Treinamento e otimização

A técnica EoRA, desenvolvida pela NVIDIA, oferece uma solução para compensar erros induzidos pela quantização. Como um método sem treinamento, pode ser aplicado rapidamente a qualquer modelo, mesmo os de maior porte, por meio de uma aproximação de baixa-rank no espaço dos autovalores. Este método mostra um potencial notável para melhorar o desempenho de modelos quantizados a 2 bits, aproximando-se da precisão de suas contrapartes em plena precisão.

“EoRA é um método simples, mas eficaz para compensar erros de quantização, mesmo em precisão de 2 bits.”

(“EoRA works.”)— NVIDIA

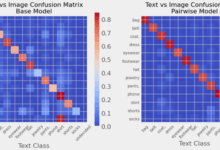

Resultados e métricas

Um estudo avaliou modelos como Qwen2.5-72B e Qwen3-32B, ambos quantizados a 2 bits. Testes mostraram uma diminuição acentuada no desempenho para as versões quantizadas. Após a aplicação do adaptador EoRA, melhorias significativas na acurácia foram observadas, especialmente no Qwen3-32B, que ganhou quase 7,5 pontos de precisão com a utilização do adaptador. O impacto do rank do LoRA foi evidente, com ranks mais altos mostrando melhorias adicionais.

“Aplicar EoRA ao Qwen3-32B rendeu um ganho de precisão significativo.”

(“Applying EoRA to Qwen3-32B resulted in a significant accuracy gain.”)— Pesquisa de Resultados

Considerando o consumo de memória, o uso do adaptador EoRA resulta em um aumento de memória que, embora presente, é geralmente considerado insignificante. Para um modelo Qwen3-14B a 2 bits, a adição do adaptador implicou em um aumento de 257 MB a 514 MB. Essa sobrecarga, em geral, não anula os benefícios da quantização, embora ranks mais altos possam resultar em um consumo que supera modelos quantizados em precisão maior.

Com resultados promissores, o método EoRA se apresenta como uma alternativa criativa para o futuro de modelos de linguagem mais acessíveis e eficientes. A pesquisa sugere que adaptar esses modelos quantizados pode abrir novas avenidas para a sua utilização em aplicações práticas, especialmente na personalização de modelos para tarefas específicas.

Fonte: (Towards Data Science – AI, ML & Deep Learning)