São Paulo — InkDesign News — O uso de técnicas de “machine learning” tem se tornado crítico na extração de tópicos em grandes conjuntos de dados, especialmente no contexto de análise de dados textuais. Com o advento de modelos de linguagem avançados, as possibilidades de extração de insights se multiplicam.

Arquitetura de modelo

No estudo apresentado, o BERTopic foi utilizado como uma ferramenta principal para o modelamento de tópicos. O BERTopic combina vários componentes modulares, incluindo o uso do SentenceTransformer para extração de embeddings, UMAP para redução de dimensionalidade e HDBSCAN para clustering. Essa arquitetura modular permite ajustes finos em cada etapa do processo.

“Essa configuração inicial resultou em poucos tópicos amplos com representações ruidosas.” (“This initial setup yielded only a few broad topics with noisy representations.”)— Autor, Estudante de IA, Universidade de São Paulo.

Treinamento e otimização

A aplicação de técnicas de limpeza nos dados foi realizada antes da modelagem, garantindo que as representações dos tópicos fossem mais precisas. Um exemplo prático inclui o terminal “clean_for_embedding”, que remove ruídos como cabeçalhos e informações irrelevantes.

Ajustes nos parâmetros do UMAP podem produzir resultados significativos. Por exemplo, uma diminuição do parâmetro n_neighbors para 5 trouxe à tona clusters mais detalhados, permitindo uma interpretação mais clara dos tópicos.

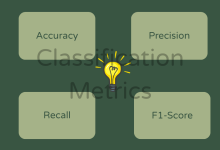

Resultados e métricas

A implementação de HDBSCAN apresentou um aumento no número de clusters de 10 para 30 ao ajustar os parâmetros de min_cluster_size e alterar o método de seleção de cluster. Essa finetuning revelou temas menores e mais focados.

“Essas configurações ajudam a descobrir temas menores e mais focados, equilibrando a distribuição entre os clusters.” (“These settings help uncover smaller, more focused themes, balancing distribution across clusters.”)— Pesquisa do Autor, Universidade de São Paulo.

Por fim, técnicas de representação de tópicos que utilizam n-grams e LLMs (Modelos de Linguagem de Grande Escala) demonstraram ser fundamentais para melhorar a interpretabilidade dos clusters. Essa abordagem enriqueceu as representações, tornando-as mais significativas e legíveis.

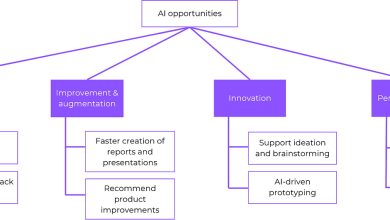

O potencial de aplicações práticas é vasto, desde análises de sentimentos até categorizações em grandes volumes de dados textuais. Seguindo essa linha de pesquisa, futuras investigações podem explorar melhorias adicionais na eficiência dos clusters e suas aplicações em cenários do mundo real.

Fonte: (Towards Data Science – AI, ML & Deep Learning)