São Paulo — InkDesign News — O campo de machine learning continua a evoluir rapidamente, impulsionado por inovações em algoritmos e novas métricas de avaliação que melhoram a confiança em aplicações reais.

Arquitetura de modelo

A integração de modelos de linguagem grandes (LLM) apresenta desafios consideráveis em sua avaliação. De acordo com a especialista Mariya Mansurova, “não sabe por onde ou como começar? Você deve avaliar todo o processo de criação de um sistema de avaliação para produtos LLM”

(“Not sure where or how to start? You should evaluate the entire process of building an evaluation system for LLM products”).

— Mariya Mansurova, Especialista em Avaliação de ML

Treinamento e otimização

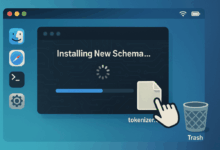

Além da arquitetura, o treinamento e a otimização de modelos é um aspecto crucial. Kenneth Leung discute a utilização de Ollama e OpenAI para avaliar “as capacidades de raciocínio de modelos baseados no DeepSeek”

(“assess the reasoning capabilities of models based on DeepSeek”).

— Kenneth Leung, Pesquisador em IA

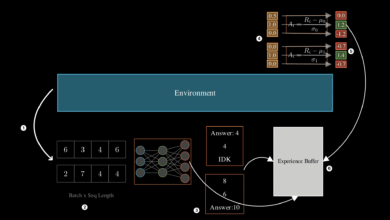

Essas abordagens possibilitam um benchmarking mais eficaz, especialmente em contextos de agentes de aprendizado por reforço, conforme analisado por Oliver S. Ele desmembra os algoritmos existentes e avalia seu desempenho.

“Aprenda a realizar experimentos no contexto de agentes de RL”

(“Learn how to run experiments in the context of RL agents”).

— Oliver S, Especialista em RL

Resultados e métricas

A análise de resultados está fortemente ligada à definição de métricas claras. James O’Brien aborda a questão ética em torno da IA, afirmando que “os usuários humanos devem refletir sobre como tratar agentes de IA treinados para emular emoções humanas”

(“how should human users treat AI agents trained to emulate human emotions”).

— James O’Brien, Especialista em Ética de IA

Portanto, a interpretação dos dados se torna crítica, e a escolha do tipo de log usado na análise é fundamental. Ngoc Doan ressalta que “usar o tipo errado de log pode gerar grandes problemas na interpretação dos resultados”

(“Using the wrong type of log can create major issues when interpreting results”).

— Ngoc Doan, Analista de Dados

À medida que continuamos a explorar deep learning e suas aplicações, a comunidade deve se concentrar em práticas robustas de avaliação para garantir a confiabilidade das ferramentas desenvolvidas. O desenvolvimento de novos benchmarks e a aplicação pragmática dos resultados serão cruciais para o avanço da pesquisa.

Fonte: (Towards Data Science – AI, ML & Deep Learning)