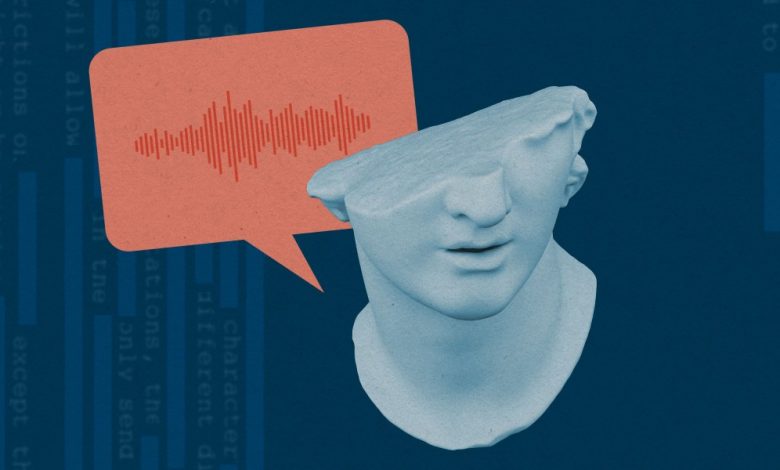

Seul — InkDesign News — Pesquisadores da Universidade Sungkyunkwan estão explorando técnicas de “machine unlearning” para aprimorar a segurança e a ética em modelos de inteligência artificial, permitindo que esses sistemas esqueçam informações potencialmente prejudiciais, como vozes indesejadas em modelos de text-to-speech.

Contexto da pesquisa

A pesquisa em questão surgiu como uma resposta à crescente preocupação sobre o uso indevido de modelos de inteligência artificial, que frequentemente possuem acesso a informações confidenciais. Os autores, incluindo Jinju Kim, estudante de mestrado da instituição, propõem que, enquanto as empresas utilizam “guarda-corpos” para limitar o acesso a dados sensíveis, o “machine unlearning” busca eliminar a informação de forma permanente. Esta abordagem se baseia em conceitos previamente explorados na área de aprendizado de máquina, mas sua aplicação em modelos de linguagem de grande escala é relativamente nova.

Método e resultados

O algoritmo em estudo envolve uma adaptação do modelo VoiceBox da Meta, focando em sua capacidade de mimetizar vozes. Para realizar o “unlearning,” os pesquisadores criaram um modelo que não apenas esquece as vozes que foi treinado para reproduzir, mas também evita imitar vozes que não foram parte do treinamento. Esse processo requer áudios de pelo menos cinco minutos de cada locutor a ser “esquecido”. Segundo os resultados apresentados, a capacidade do modelo de imitar uma voz “esquecida” reduz em mais de 75% a eficácia comparado ao modelo anterior, embora haja uma leve perda de 2,8% na performance para vozes permitidas.

Implicações e próximos passos

As aplicações práticas do “machine unlearning” incluem a proteção de informações pessoais e a mitigação de riscos éticos associados ao uso de inteligência artificial. Contudo, os desafios permanecem, especialmente no que se refere à complexidade dos modelos e à necessidade de eficiência. Como observa Kim, “Você não pode simplesmente pular o cercado; algumas pessoas ainda tentarão ir por baixo ou por cima.” Essa pesquisa representa um passo crucial em direção a métodos mais éticos e seguros na aplicação de tecnologias de inteligência artificial.

A pesquisa sugere que as “vozes esquecidas” ao serem alimentadas ao modelo, resultam em gerações fictícias mais realistas.

(“When prompted to produce a text sample in one of the voices to be redacted, it should instead respond with a random voice.”)— Jinju Kim, Estudante de Mestrado, Universidade Sungkyunkwan

Esse avanço demonstra um potencial significativo para abordar preocupações éticas nas práticas de aprendizado de máquina. A busca por soluções efetivas continua, moldando o futuro da inteligência artificial.

Fonte: (MIT Technology Review – Artificial Intelligence)