Contexto da pesquisa

Atlanta — InkDesign News — Pesquisadores do Georgia Institute of Technology desenvolveram um sistema inovador para investigação forense de falhas em sistemas de inteligência artificial (IA), especialmente em modelos de machine learning (aprendizado de máquina). A ferramenta, chamada AI Psychiatry (AIP), permite “reanimar” modelos de IA que falharam para entender exatamente o que deu errado, abordando a crescente necessidade de transparência e diagnóstico em IA aplicada a sistemas críticos como veículos autônomos.

Método proposto

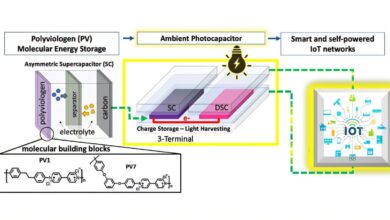

O AI Psychiatry utiliza técnicas forenses digitais para recuperar o modelo de IA a partir de uma imagem de memória (memory image), ou seja, a captura dos bits e bytes ativos no momento em que a IA estava operando. Com isso, o sistema reconstrói funcionalmente o modelo, que pode ser testado em ambiente controlado. Isso permite avaliar decisões e comportamentos do modelo sob diversas condições, inclusive ataques maliciosos, sem necessitar acesso prévio ao código-fonte ou dados internos da IA. O método é baseado em algoritmos genéricos que abordam os componentes universais dos modelos de machine learning, facilitando a aplicação a diversas arquiteturas e frameworks populares.

Resultados e impacto

Em testes com 30 modelos de IA, dos quais 24 continham “backdoors” (portas traseiras) para gerar resultados incorretos mediante estímulos específicos, o AI Psychiatry conseguiu recuperar, reconstituir e analisar todos os modelos com sucesso. Isso inclui modelos usados para reconhecimento de placas de trânsito em veículos autônomos, cenário exemplificado pela pesquisa. O sistema possibilita identificar vulnerabilidades internas da IA que possam ter causado falhas, ou descartá-las para focar em outras causas externas, como falhas em sensores.

“Imagine uma investigação detalhada que permite reconstituir o processo decisório de uma IA no momento exato da falha para determinar sua causa.”

(“Imagine a detailed investigation that allows reconstructing the decision-making process of AI at the exact moment of failure to determine its cause.”)— pesquisadores do Georgia Institute of Technology

Por ser open source, o AI Psychiatry pode ser utilizado por investigadores, auditores e órgãos governamentais para reforçar a segurança e a confiabilidade de sistemas de IA em diferentes setores, de veículos autônomos a assistência médica e drones. Além disso, a ferramenta tem potencial para ser integrada em auditorias preventivas, contribuindo para a integridade dos modelos antes que falhas críticas ocorram.

Essa inovação representa um avanço significativo para o campo de machine learning, pois oferece um método eficaz e reproduzível para análise pós-falha, preenchendo uma lacuna importante na segurança e regulamentação de IA.

Veja mais sobre machine learning: machine learning e deep learning.

Fonte: (TechXplore – Machine Learning & AI)