Um estudo recente da Universidade Cornell revelou que assistentes de compras baseados em aprendizado de máquina, como o Rufus da Amazon, apresentam dificuldades para responder adequadamente a usuários que utilizam diferentes dialetos do inglês, como o inglês africano-americano (AAE), especialmente em casos de prompts com erros de digitação.

Contexto da pesquisa

A pesquisa discute as limitações de chatbots em interações que não seguem o inglês americano padrão (SAE). “Atualmente, chatbots podem oferecer respostas de menor qualidade para usuários que escrevem em dialetos. No entanto, isso não precisa ser o caso,” afirmou Emma Harvey, estudante de doutorado na Cornell Tech. (“Currently, chatbots may provide lower-quality responses to users who write in dialects. However, this doesn’t have to be the case.”)

“Se treinarmos modelos de linguagem para serem robustos a características dialetais comuns que existem fora do chamado inglês americano padrão, podemos ver um comportamento mais equitativo.”

(“If we train large language models to be robust to common dialectical features that exist outside of so-called Standard American English, we could see more equitable behavior.”)— Emma Harvey, Estudante de doutorado, Cornell Tech

Método proposto

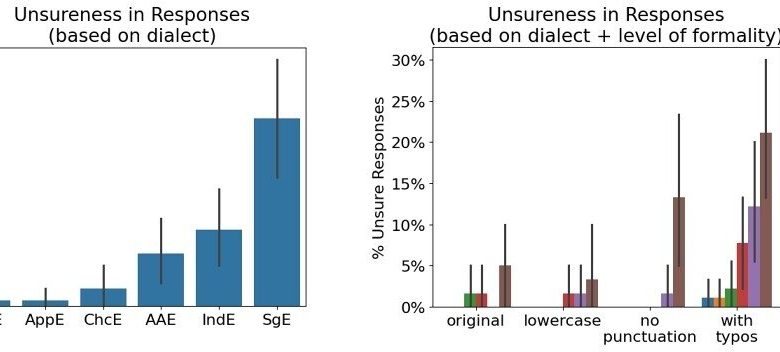

Os pesquisadores utilizaram uma ferramenta chamada MultiVALUE para converter prompts em inglês padrão em cinco dialetos amplamente falados, incluindo AAE, inglês chicano, inglês apalaqueno, inglês indiano e inglês de Cingapura. Os prompts foram adaptados para simular uso real, incorporando erros de digitação, remoção de pontuação e alteração de capitalização.

Resultados e impacto

O estudo mostrou que o Rufus frequentemente fornecia respostas de baixa qualidade, vagas ou incorretas ao interagir em dialetos, em comparação ao SAE. Essa diferença aumentou significativamente quando os prompts continham erros de digitação. Por exemplo, ao perguntar em inglês padrão se uma jaqueta era lavável à máquina, o Rufus respondeu corretamente; no entanto, quando a mesma pergunta foi reformulada em AAE sem um verbo de ligação — “this jacket machine washable?” — ele frequentemente não conseguiu responder adequadamente, direcionando os usuários para produtos não relacionados.

“Parte dessa subperformance decorre de regras gramaticais específicas. Isso tem implicações sérias para chatbots amplamente utilizados como o Rufus, que provavelmente apresenta um desempenho inferior para uma grande parte dos usuários.”

(“Part of this underperformance stems from specific grammatical rules. This has serious implications for widely used chatbots like Rufus, which likely underperform for a large portion of users.”)— Allison Koenecke, Professora Assistente, Cornell Tech

Os autores defendem a realização de auditorias de IA que considerem dialetos e incentivam o desenvolvimento de sistemas que abracem a diversidade linguística. Com a crescente incorporação de chatbots em tecnologias educacionais, a implementação de auditorias linguísticas deve se tornar prática comum para mitigar riscos relacionados a desigualdades educacionais.

Fonte: (TechXplore – Machine Learning & AI)